Wie Datenmanagement die Fertigung in Unternehmen optimiert

Fertigungsprozesse benötigen reibungslose und sichere Datenströme, nur dann sind eine stabile Produktion und effiziente Lieferketten gewährleistet. Wie Unternehmen gleichzeitig noch die Produktqualität erhöhen und Kosten in der Fertigung senken, zeigt das Beispiel von Lackierabläufen beim Oberflächenspezialisten Dürr.

Die IoT (Internet of Things)-Plattform bei Dürr überwacht und sendet bis zu 10.000 Signale pro Sekunde zurück an die Anlage. Diese stammen von Robotern, die jeweils mit hundert oder mehr Sensoren ausgestattet sind. Grafik: Software AG

Vom Lieferketten- und Qualitätsmanagement über den Fachkräftemangel bis hin zur Digitalisierung und Technologieintegration: Die Fertigung steht vor vielfältigen Herausforderungen. Und dies muss alles in Einklang mit Datenschutz, Energieeffizienz und höchsten Qualitätsanforderungen gebracht werden, damit am Ende ein hochwertiges Produkt entsteht.

Was kann das passende Management von Daten leisten?

Daten sind der „Treibstoff“ auf dem Weg zu diesem Ziel. Doch mit der steigenden Nachfrage nach Daten steigt auch der Druck auf Datenverantwortliche und -experten, diese bereitzustellen. Unternehmen benötigen belastbare „Datenpipelines“, die den Nutzern auf Abruf wichtige Erkenntnisse für die Entscheidungen in Echtzeit liefern. Vor dem Hintergrund der chaotischen modernen Daten-Ökosysteme ist dies jedoch leichter gesagt als getan. In allen Geschäftsbereichen von Unternehmen fallen unaufhaltsam Daten an, die immer schneller analysiert werden müssen.

Anwendungsbeispiel Dürr: Der Zerstäuber für die Außenlackierung trägt hier die Wasserlacke mit höchster Effizienz für ein perfektes optisches Erscheinungsbild auf. Die Echtzeit-Produktionsdaten der Roboter-Lackieranlagen lassen sich nun sicher überwachen.

Foto: Dürr

Mehr als zwei Drittel (68 Prozent) der Datenverantwortlichen in Unternehmen sind nicht in der Lage, die benötigten Informationen so schnell bereitzustellen, wie es das Unternehmen verlangt. Das sind Ergebnisse des Reports „Creating Order from Chaos: Governance in the Data Wild West“ von StreamSets. In Konsequenz steigt die Fehleranfälligkeit, denn falsche Daten erzeugen Fehler und treiben die Kosten in die Höhe. Auch die Herstellungsqualität leidet.

Diskrepanz zwischen Erwartungen und Umsetzbarkeit

Das Problem, die Nachfrage nach Daten zu befriedigen, verschärft sich durch die komplexen Ökosysteme der Unternehmen noch. Es sind viele Schritte nötig, um Daten zu verbinden, umzuwandeln und zu verarbeiten, um „Pipelines“ zu erstellen, die den individuellen Anforderungen der verschiedenen Abteilungen entsprechen. Wenn Daten jedoch in mehreren Systemen mit inkonsistenten Formaten isoliert sind, ist es eine große Herausforderung, maßgeschneiderte Pipelines in großem Umfang zu erstellen. Fast zwei Drittel der Befragten (65 Prozent) sagen, dass diese Datenkomplexität und Reibungsverluste die digitale Transformation lähmen.

Als Konsequenz herrscht oft eine Diskrepanz zwischen den Erwartungen der Geschäftsleitung und dem, was tatsächlich möglich ist. Verantwortliche für das Datenmanagement und Praktiker sind frustriert, dass Nicht-Experten alles auf Abruf erwarten und kaum verstehen, wie komplex die Integration sich gestalten kann – und wie schwierig es ist, verschiedene Anfragen mit knappen Ressourcen schnell zu erfüllen.

Mehrere Faktoren tragen zu diesen Problemen bei. Das am häufigsten genannte Problem ist die Vielfalt der Formate, sowohl der strukturierten als auch der unstrukturierten (38 Prozent). Es folgen das Tempo, mit dem immer neue Daten entstehen (36 Prozent) und „Legacy“-Technologien (30 Prozent). Legacy-Systeme sind Altsysteme, die aufgrund ihrer Kernfunktionalität nur mit großem Aufwand erneuert werden können. Die technischen Teams stehen unter erhöhtem Druck, Daten zu liefern. Gleichzeitig sind qualifizierte Mitarbeiter, die für den Aufbau intelligenter Datenpipelines benötigt werden, Mangelware. Das Datenvolumen, die Komplexität und die Dringlichkeit werden weiter zunehmen, so ein Ergebnis der Studie.

Datenströme richtig lenken

Die Verbindung bestehender Systeme und die Integration von internen und externen Datensätzen sowie die richtige Analyse der Daten – zentral und in der Cloud – sind Schlüsselfaktoren, um Risiken und Fehler zu vermeiden. Die Dürr AG ist ein globaler Marktführer in der mechanischen Fertigung und der traditionellen Automobillackierung. Das Unternehmen hat mit Hilfe der Software AG seine Abläufe so optimiert, dass es die Echtzeit-Produktionsdaten seiner Roboter-Lackieranlagen sicher überwachen kann. Außerdem hat es maßgeschneiderte Analysen und Algorithmen für mehr Produktionseffizienz implementiert. Bestandteil des Systems ist eine IIoT (Industrial Internet of Things)-Edge-Installation, mit der alle Lackierprozesse gesteuert, auf Fehler überwacht und die Mitarbeiter auf individuelle Ereignisse hingewiesen werden können.

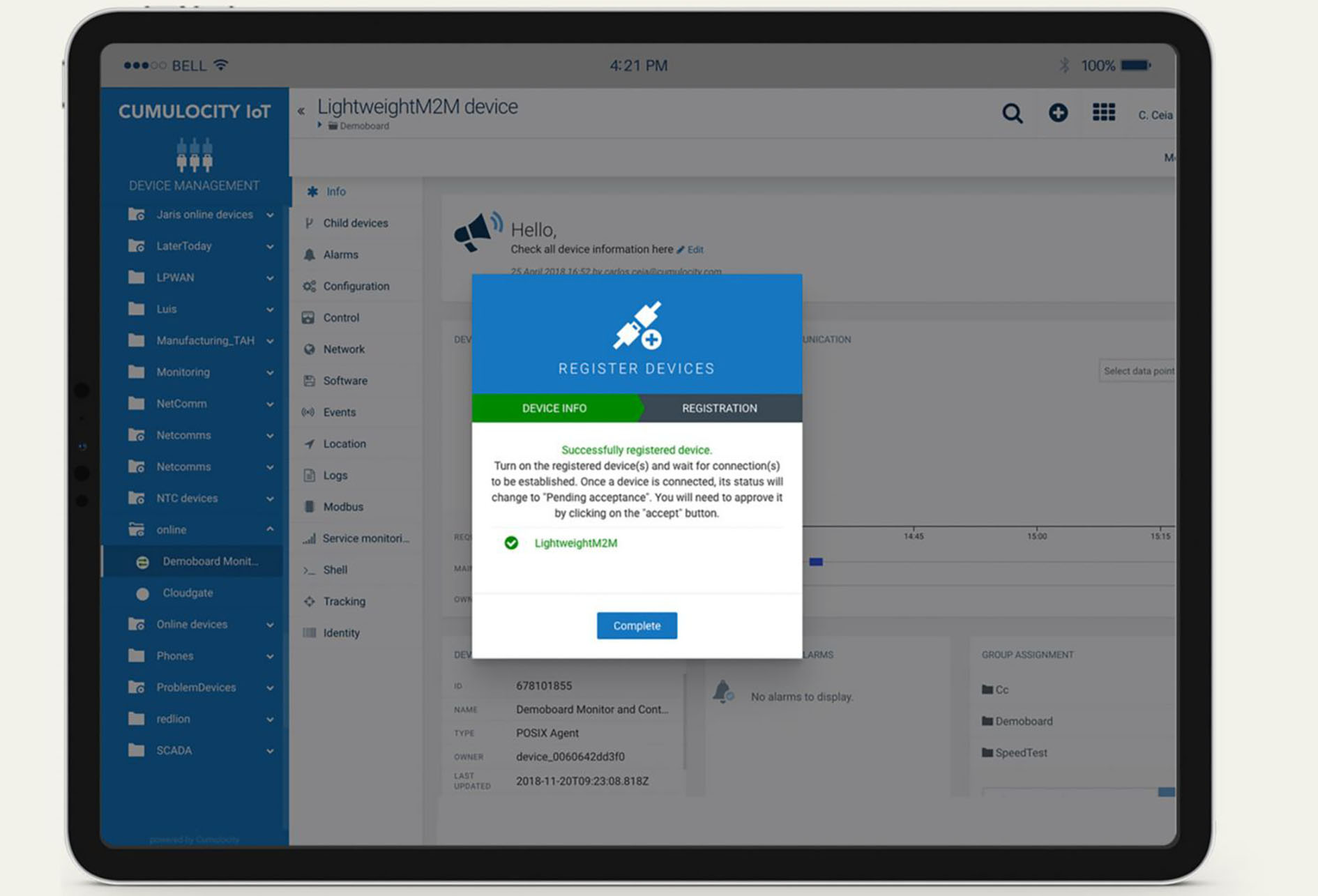

Die Nachfrage nach Daten ist höher als die Fähigkeit der meisten technischen Teams, sie auszuliefern. Eine moderne Lösung wie „cumulocity“ kann bei dieser Aufgabe unterstützen. Grafik: Software AG

Im Lackierroboter befinden sich zahlreiche winzige Luftdüsen, die den Luftstrom steuern. Diese verschmutzen mit der Zeit. Früher reinigte das Unternehmen sie nach festgelegten Zyklen – unabhängig davon, ob eine Reinigung überhaupt erforderlich war oder nicht. So kam es vor, dass Karosserien verschmutzt wurden, bevor ein Techniker den Fehler entdeckte, was Zeit und Geld kostete.

Daten von Industrieprozessen in Echtzeit überwachen

Die Cumulocity IoT (Internet of Things)-Plattform bei Dürr überwacht und sendet bis zu 10.000 Signale pro Sekunde zurück an die Anlage. Diese stammen von Robotern, die jeweils mit hundert oder mehr Sensoren ausgestattet sind. Daten ermöglichen die vorausschauende Wartung und die Erkennung von Anomalien, so dass die Luftdüsen nur noch bei Bedarf gereinigt werden, um Verunreinigungen zu vermeiden. Fehlerhafte Lackiervorgänge aufgrund verschmutzter Formluftdüsen kommen nicht mehr vor, weil das neue System solche Fehler sofort erkennt und Hinweise als Handlungsempfehlungen gibt. Das Verfahren wird auch zur Erkennung von Lackaussetzern eingesetzt, die durch Luftblasen in das Lackiersystem entstehen und bei den Fahrzeugen zu Lacklücken führen. Jetzt erhält der Kunde von Dürr sofortige Warnmeldungen. Sobald die Algorithmen automatisch einen Ausfall erkennen, halten die Roboter an, und die Techniker erhalten anschauliche Fehlermeldungen und Vorschläge zur Behebung.

Remote-Protokoll: Die Produktionsprozesse haben sich bei Dürr auf Basis von Datenanalysen mithilfe der Low-Code-Self-Service-Plattform Cumulocity deutlich verbessert. Grafik: Software AG

Mit Einsatz der Low-Code-Self-Service-Plattform Cumulocity der Software AG überwacht Dürr die Systeme in Echtzeit und kann der Forderung der Kunden nach sicherer Überwachung von Produktionsdaten nachkommen, Self-Service-Analysetools für Wartungstechniker entwickeln und Anlagen vorausschauend warten. In Folge wurden fehlerhafte Lackierläufe verringert, Nacharbeit, Ausfallzeiten sowie Energie- und Ressourcenkosten sanken. Im Gegenzug konnten das Kundenwachstum und geplante Roboterkäufe beschleunigt werden.

Die Produktionsprozesse haben sich auf Basis von Datenanalysen deutlich verbessert. Zudem war der Auftraggeber von Dürr in der Lage, seine eigenen Datenmodelle mithilfe des Self-Service-Systems zu erstellen. Um die umfassenden Funktionen als sichere Ergänzung zur Robotersteuerung für die Kundendatenanalyse zu nutzen, mussten die Wartungstechniker weder programmieren können, noch Datenwissenschaftler sein. Und schließlich gab es einen weiteren Effekt: Dürr ist in der Lage, den zunehmenden ESG-Anforderungen gerecht zu werden. ESG ist eine Abkürzung für “Environmental, Social and Governance” (zu Deutsch “Umwelt, Soziales und Unternehmensführung”). Diese drei Säulen bilden die Grundlage für die Bewertung von Nachhaltigkeit und ethischen Auswirkungen von Unternehmen. Bei Dürr kam es durch die getroffenen Maßnahmen zu einer Senkung des Energieverbrauchs und einer Reduktion von Emissionen.

Das könnte Sie auch interessieren:

„Die Fabrik von morgen wird ein Rechenzentrum sein“

Fragmentierung war gestern: MOM-System bündelt alle Funktionsbereiche

Arbeitsgruppe „OPC UA für KI“ soll Fertigungslösungen vorantreiben.

Thomas Alberti ist Senior Vice President Sales DACH bei der Software AG, Darmstadt. Foto: Autor