Dank Funksicht navigieren Roboter sicher durch Nebel und Rauch

Übermenschliche Sicht: Ein neuartiger Sensor nutzt Funksignale, um die Umgebung detailgenau zu erfassen. Das funktioniert selbst bei Nebel und Rauch.

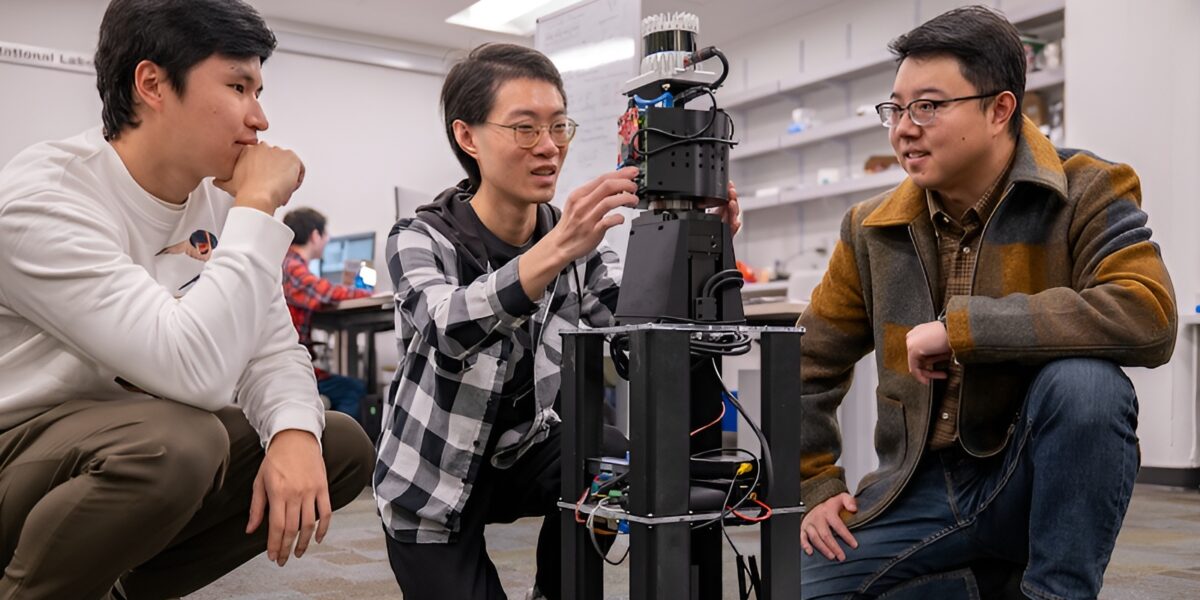

Freddy Liu, Haowen Lai und Mingmin Zhao (von links) bereiten einen mit PanoRadar ausgestatteten Roboter für einen Testlauf vor. Dank Funksicht kann er sicher durch Rauch und Nebel navigieren.

Foto: Sylvia Zhang

Herkömmliche Sensoren wie Kameras und LiDAR stoßen bei Nebel, Rauch oder anderen ungünstigen Wetterbedingungen schnell an ihre Grenzen. Ein Forschungsteam der University of Pennsylvania hat mit dem sogenannten PanoRadar einen neuartigen Sensor entwickelt, der Funksignale nutzt, um die Umgebung detailgenau zu erfassen. Dieses System verleiht Robotern eine Art „übermenschliche“ Sicht und ermöglicht ihnen, auch unter widrigen Bedingungen präzise zu navigieren.

Inhaltsverzeichnis

Funksignale als Alternative zu Licht und Radar

Organismen in der Natur haben es vorgemacht: Fledermäuse navigieren durch Echoortung, Haie spüren elektrische Felder auf. Diese Strategien zeigen, dass visuelle Wahrnehmung nicht allein auf Licht angewiesen sein muss. So wie Schall- oder elektrische Signale durch verschiedene Materialien dringen, können auch Radiowellen Nebel und Rauch überwinden. Radiowellen besitzen eine viel größere Wellenlänge als Licht, was ihnen hilft, durch einige Hindernisse „hindurchzusehen“.

PanoRadar baut auf dieser Idee auf und kombiniert Funktechnologie mit KI. Während Kameras und LiDAR detaillierte Bilder liefern, aber oft durch Staub oder dichte Nebel blockiert werden, ist herkömmliches Radar zwar durchdringend, jedoch in der Auflösung begrenzt. PanoRadar hingegen schafft es, beide Stärken zu vereinen.

„Unsere erste Frage war, ob wir das Beste aus beiden Erfassungsmodalitäten kombinieren können“, erklärt Mingmin Zhao, Assistenzprofessor für Computer- und Informationswissenschaft.

Rotierende Antennen sorgen für den Durchblick

Das Herzstück von PanoRadar ist eine rotierende Antennenanordnung. Wie ein Leuchtturm schwenkt sie im Kreis und tastet die gesamte Umgebung ab. Dabei senden die Antennen Radiowellen aus und empfangen ihre Reflexionen, um so ein Bild der Umgebung zu erzeugen. Dank einer speziellen Signalverarbeitungstechnik, die durch KI gestützt ist, verarbeitet PanoRadar die Messdaten und erstellt detaillierte 3D-Ansichten.

Durch die Rotation entstehen „virtuelle Messpunkte“, die ein dichtes Bild ergeben, das mit der Auflösung eines LiDAR-Systems vergleichbar ist. „Die entscheidende Innovation liegt in der Art und Weise, wie wir diese Funkwellenmessungen verarbeiten“, so Zhao.

Hochauflösende Bilder auch bei Bewegung

Eine der größten Herausforderungen für das Team bestand darin, die Bildqualität auch bei Bewegung des Roboters beizubehalten. Haowen Lai, Hauptautor des Forschungsberichts, erläutert: „Um mit Funksignalen eine mit LiDAR vergleichbare Auflösung zu erreichen, mussten wir Messungen von verschiedenen Positionen kombinieren.“ Jeder Messpunkt musste dabei mit höchster Präzision erfasst werden, was durch kleine Bewegungsfehler erschwert wird.

Ein zusätzlicher Vorteil von PanoRadar ist seine Fähigkeit, Glasoberflächen zu erkennen – eine Aufgabe, an der viele herkömmliche Systeme scheitern. Auch in Gebäuden, die durch Rauch gefüllt sind, behält der Roboter seine Orientierung und kann die Struktur präzise kartieren.

„Unsere Feldtests in verschiedenen Gebäuden haben gezeigt, wie sich die Funksensorik dort auszeichnen kann, wo herkömmliche Sensoren an ihre Grenzen stoßen“, erklärt die Forschungsassistentin Yifei (Freddy) Liu.

KI und Mustererkennung zur Umweltanalyse

Neben der Erfassung ist die Interpretation der Daten ein entscheidender Teil von PanoRadar. Gaoxiang Luo, eine der Mitwirkenden im Team, betont die Rolle konsistenter geometrischer Muster im Innenbereich. Durch maschinelles Lernen wurden diese Muster genutzt, um der KI zu helfen, das Gesehene zu verstehen. Um die Genauigkeit zu steigern, stimmte das System seine Analysen anfangs mit LiDAR-Daten ab und verbesserte sich durch kontinuierliches Lernen.

Diese Kombination aus Funk und KI befähigt PanoRadar zu hoher Präzision und robuster Wahrnehmung. Bei zukünftigen Einsätzen könnte diese Technologie Roboter sicherer und effektiver durch gefährliche Umgebungen führen – ob bei Rettungsmissionen, in der Industrie oder im autonomen Transportwesen.

Ausblick: Multisensorische Wahrnehmungssysteme

Das Team um Zhao plant, PanoRadar weiter zu verbessern und es mit anderen Sensortechnologien wie Kameras und LiDAR zu kombinieren. Ziel ist es, robuste, multimodale Wahrnehmungssysteme für anspruchsvolle Aufgaben zu schaffen. Durch die Kombination verschiedener Sensoren können Roboter in Zukunft flexibler agieren und sich den komplexen Herausforderungen der realen Welt anpassen.

„Für Aufgaben mit hohem Risiko ist es entscheidend, über mehrere Möglichkeiten zur Wahrnehmung der Umgebung zu verfügen“, so Zhao. „Jeder Sensor hat seine Stärken und Schwächen, und durch eine intelligente Kombination können wir Roboter entwickeln, die besser für die Herausforderungen der realen Welt gerüstet sind.“

Ein Beitrag von: