Google stellt mit Gemini Robotics KI-Modell für Roboter vor

Mit dem KI-Modell Gemini Robotics, das auf Gemini 2.0 basiert, ermöglicht Google die Mensch-Maschine-Interaktion via Sprache.

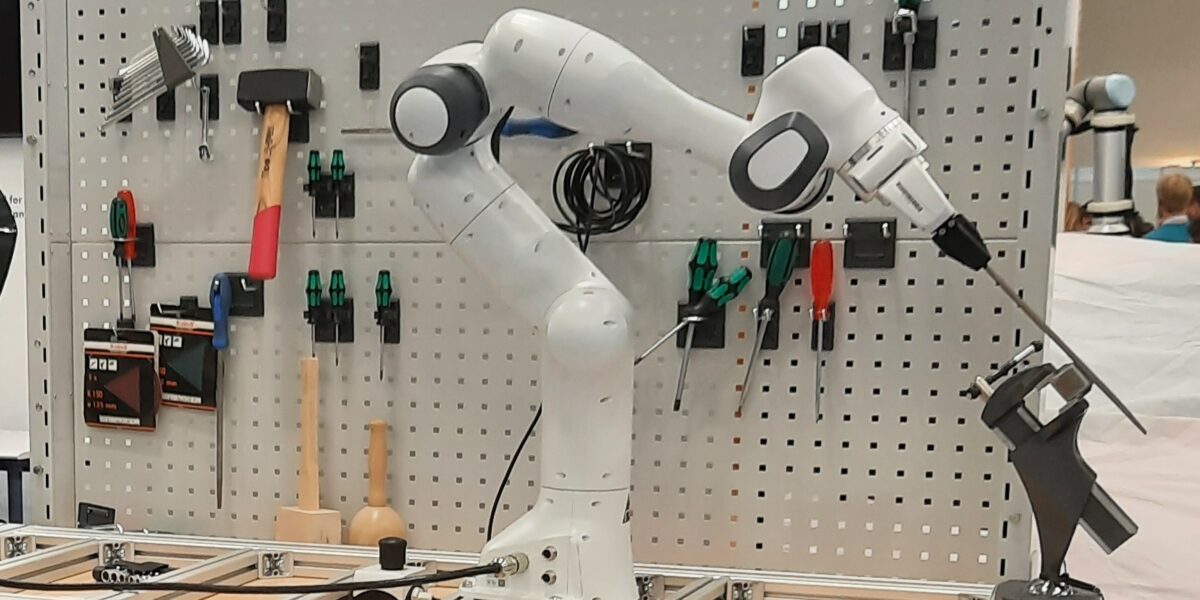

Mit Gemini Robotics setzt Google ein Ausrufezeichen beim KI-Einsatz in der Robotik. Das Unternehmen stellte jetzt unter anderem Anwendungen auf Basis von Robotern des Herstellers Franka Emika vor. Das Bild zeigt dieses Modell in einer Laboranwendung der Technischen Universität München auf der Messe Automatica.

Foto: M. Ciupek

Als Vision-Language-Action-Modell (VLAM) bezeichnet Google Deepmind seine jüngste Lösung „Gemini Robotics“. Das KI-Modell soll es Robotern ermöglichen, ein breiteres Spektrum an Aufgaben in der realen Welt auszuführen als je zuvor. Damit wird deutlich, dass neben Sprache auch Bildinformationen und physische Interaktionen von Robotern mit ihrem Umfeld von dem Modell berücksichtigt werden. Die Ergebnisse übersetzt die Software dann direkt in Steuerungsbefehle, die die Roboter direkt verarbeiten können.

Das zweite KI-Modell ist Gemini Robotics-ER. Neben einem räumlichen Verständnis der Umgebung bringt dieses Modell die Embodied-Reasoning-(ER)-Fähigkeiten von Gemini in die Robotik. In dem Modell sind demnach passende Denk- und Handlungsansätze hinterlegt, die auf die jeweilige Situation angewendet werden.

Google Deepmind demonstriert KI in Alltagsbeispielen

In einem Blogbeitrag zeigt Google Deepmind, wie ein Roboter mit den neuen KI-Modellen beispielsweise darauf reagiert, wenn ein zu greifendes Objekt im Greifvorgang verschoben wird. Die Roboter erkennen ihr Umfeld und können damit laut dem Unternehmen auch Aufgaben übernehmen, die ein gewisses Geschick erfordern – beispielsweise das Zubinden von Schnürsenkeln.

Demonstriert wird der Effekt auch in einem Video, das zeigt, wie zwei kognitive Roboter von Hersteller Franka Emika einen Zahnriemen über zwei Zahnräder legen. Dazwischen befindet sich dabei noch ein Spanner, der im Sprachdialog mit dem Bediener als solcher definiert wird.

Hier geht es zum Video:

Hier wird Ihnen ein externer Inhalt von youtube.com angezeigt.

Mit der Nutzung des Inhalts stimmen Sie der Datenschutzerklärung

von youtube.com zu.

Das Unternehmen zeigt in dem Blogbeitrag darüber hinaus, wie Roboter in Alltagssituationen interagieren. Beispiele dafür sind beispielsweise das Aufräumen eines Schreibtisches, auf dem Stifte, Blöcke sowie Spielzeug liegen. Ein anderes Beispiel zeigt den Umgang mit Obst und Obstschalen in einer Küchenumgebung. Der KI-unterstützte Roboter reagiert dabei sowohl auf Sprachanweisungen des Bedieners als auch auf seine Aktionen – wie das Verschieben von Gegenständen.

Gemini Robotics setzt Sprachbefehle in Handlungen um

Zur Interaktivität schreibt Google: „Um in unserer dynamischen, physischen Welt zu funktionieren, müssen Roboter in der Lage sein, nahtlos mit Menschen und ihrer Umgebung zu interagieren und sich spontan an Veränderungen anzupassen.“ Auf Grundlage von Gemini 2.0 sei Gemini Robotics intuitiv interaktiv. „Er nutzt die fortschrittlichen Sprachverständnisfähigkeiten von Gemini und kann Befehle in Alltags- und Umgangssprache sowie in verschiedenen Sprachen verstehen und darauf reagieren“, heißt es.

Laut Google kann er dabei eine viel größere Anzahl von Anweisungen in natürlicher Sprache verstehen und darauf reagieren, als es frühere Modelle des Konzerns konnten. Der Roboter passe sein Verhalten damit an die jeweiligen Eingaben an. Darüber hinaus überwacht das System nach Herstellerangabe ständig seine Umgebung. Es erkennt somit Veränderungen in der Arbeitsumgebung und passt seine Handlungen entsprechend an. Damit lasse sich Zusammenarbeit zwischen Mensch und Roboterassistent in verschiedenen Bereichen, von zu Hause bis zum Arbeitsplatz, verbessern.

Geschicklichkeit: Roboter bekommt motorische Fähigkeiten

Bisher ließen sich viele Anwendungen wegen mangelnder Geschicklichkeit der Roboter nicht oder nur mit großem Aufwand automatisieren. Das liegt daran, dass viele alltägliche Aufgaben, die Menschen mühelos ausführen, feine motorische Fähigkeiten erfordern. Für Roboter galten diese deshalb als zu schwierig. Laut Google kann Gemini Robotics nun solche hochkomplexen, mehrstufigen Aufgaben dank KI-Unterstützung bewältigen. Ein Beispiel dafür ist das Falten von Origami oder das Verpacken eines Snacks in einen Beutel mit Zip-Verschluss.

Gemini Robotics lässt sich auf verschiedene Robotertypen anpassen

Verschiedene Robotermodelle können bereits mit den KI-Modellen gesteuert werden. In erster Linie wurden sie dazu bisher mit Daten der zweiarmigen Roboterplattform Aloha 2 trainiert. Gleichzeitig zeigen Videos, wie Plattformen mit zwei Armen von Franka Emika mit der KI angesteuert werden können. Diese werden in vielen akademischen Labors verwendet.

Auch komplexe Robotermodelle wie Humanoide von Apptronik hat Google mit Gemini Robotics längst im Visier. Ein Anwendungsbeispiel zeigt beispielsweise den humanoiden Apollo-Roboter bei einem Buchstabenspiel und in einer Haushaltssituation. Laut Google wurde Gemini Robotics so konzipiert, dass es sich leicht an verschiedene Robotertypen anpassen lässt.

Ein Beitrag von: