MIT-Ingenieure wollen Haushaltsroboter mit „gesundem Menschenverstand“ ausstatten

Mit Hilfe eines großen Sprachmodells haben MIT-Ingenieure Roboter in die Lage versetzt, sich nach Fehltritten selbst zu korrigieren und ihre Arbeit fortzusetzen.

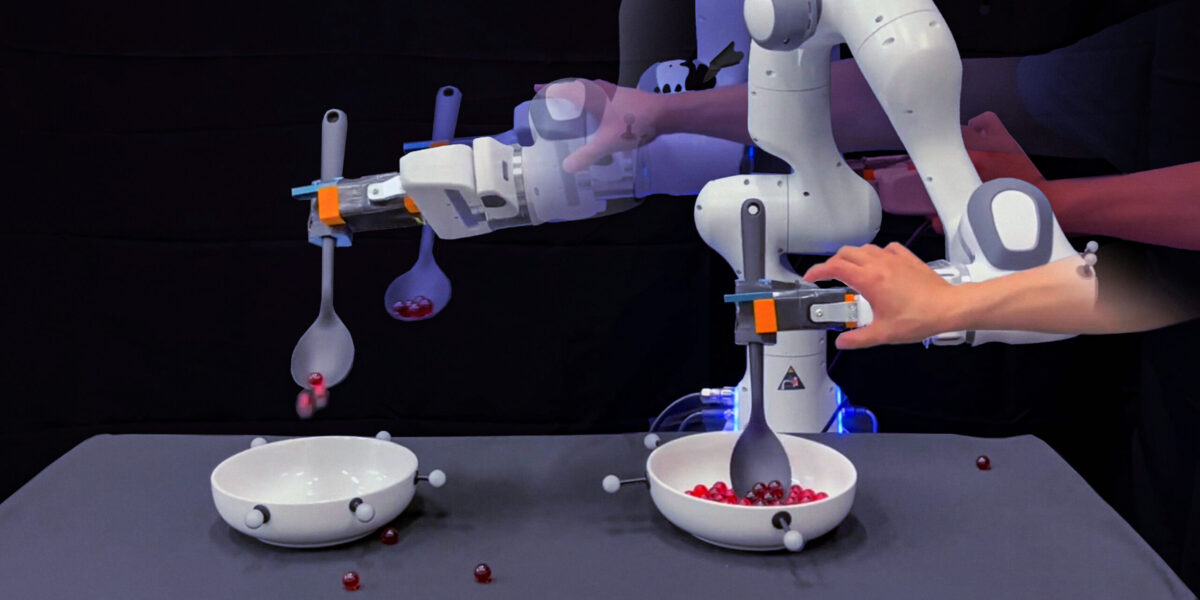

Auf dieser Collage versucht eine Roboterhand, rote Murmeln aufzusammeln und in eine andere Schale zu legen, während die Hand eines Forschers sie häufig unterbricht. Schließlich gelingt es dem Roboter.

Foto: Jose-Luis Olivares, MIT

Haushaltsroboter werden zunehmend mit anspruchsvolleren Aufgaben betraut, die vom Aufwischen verschütteter Getränke bis zum Servieren von Mahlzeiten reichen. Diese Roboter erwerben ihre Fähigkeiten hauptsächlich durch Nachahmung menschlicher Handlungen, indem sie so programmiert werden, dass sie gezeigte Bewegungen imitieren. Dabei erweisen sie sich als sehr gute Nachahmer.

Beim selbständigen Umgang mit Unebenheiten und Hindernissen stoßen sie jedoch an ihre Grenzen, sofern sie nicht explizit darauf programmiert wurden. In solchen Fällen bleibt ihnen oft nur, die Aufgabe von vorne zu beginnen. Um diese Herausforderung zu meistern, wollen Ingenieure des Massachusetts Institute of Technology (MIT) den Robotern nun die Fähigkeit verleihen, sich selbstständig an abweichende Situationen anzupassen und durch die Integration von „gesundem Menschenverstand“ auf Kurs zu bleiben.

Verknüpfung mit großen Sprachmodellen

Die MIT-Ingenieure haben eine Methode entwickelt, die Bewegungsdaten von Robotern mit dem „gesunden Menschenverstand“ großer Sprachmodelle (Large Language Models, LLMs) verbindet. Die von dem Team vorgestellte Methode ermöglicht es Robotern, komplexe Haushaltsaufgaben in überschaubare Abschnitte zu unterteilen und innerhalb dieser Abschnitte auf Herausforderungen zu reagieren. So können sie ihre Arbeit fortsetzen, ohne bei jeder Störung von vorne beginnen zu müssen, und Ingenieure müssen nicht für jede denkbare Fehlerquelle vorab spezifische Lösungen programmieren.

„Lernen durch Imitation ist eine weit verbreitete Methode, um Robotern Aufgaben beizubringen. Problematisch wird es jedoch, wenn ein Roboter die Handlungen eines Menschen ohne Rücksicht auf mögliche Fehler nachahmt, was die Gesamterfüllung der Aufgabe gefährden kann“, erklärt Yanwei Wang, Doktorand am MIT Department of Electrical Engineering and Computer Science (EECS). „Unser Ansatz ermöglicht es dem Roboter, Fehler in der Ausführung selbstständig zu erkennen und zu korrigieren, was die Effizienz und die Erfolgsquote bei der Aufgabenerfüllung steigert“.

Roboter muss Murmeln von einer zur anderen Schale überführen

Das Forscherteam demonstriert die Wirksamkeit seines Ansatzes anhand einer scheinbar einfachen Tätigkeit: dem Umfüllen von Murmeln von einer Schale in eine andere. Normalerweise würden Ingenieure einen Roboter anweisen, das Aufnehmen und Umfüllen in einer fließenden Bewegung zu imitieren, indem sie diese Handlungen wiederholt ausführen, um dem Roboter verschiedene menschliche Vorgehensweisen beizubringen. „Aber die menschliche Demonstration ist eine einzige lange, kontinuierliche Bahn“, erläutert Wang.

Es wurde festgestellt, dass die Vorführung durch eine Person, obwohl sie als ein kontinuierlicher Vorgang erscheint, in Wirklichkeit aus mehreren aufeinander folgenden Teilhandlungen besteht. Beispielsweise muss ein Roboter zuerst nach der Schüssel greifen, bevor er die Murmeln schöpfen kann. Ebenso muss er die Murmeln aufgenommen haben, bevor er sich dem Ablegen zuwendet, und so weiter. Wenn der Roboter während einer solchen Teilhandlung auf ein Problem stößt, hat er keine andere Wahl, als die Handlung abzubrechen und von vorne zu beginnen, es sei denn, die Ingenieure markieren jede Teilhandlung deutlich und bereiten zusätzliche Demonstrationen vor, die es dem Roboter ermöglichen, solche Fehler selbstständig zu korrigieren. „Diese Art der Planung ist sehr mühsam“, sagt Wang.

LLMs übernehmen Teil der Arbeit

Dem Roboter beizubringen, bei Störungen einfach weiterzumachen, ist mit gängigen Methoden kaum möglich: „Diese Art der Planung ist sehr mühsam“, sagt Wang. Wang und sein Team entdeckten, dass LLMsin der Lage sind, einen erheblichen Teil der Arbeit zu automatisieren. Diese fortschrittlichen Deep-Learning-Systeme durchsuchen große Textsammlungen, um Muster und Beziehungen zwischen Wörtern, Sätzen und Textabschnitten zu erkennen. Mit diesem Wissen sind sie in der Lage, neue Texte zu generieren, die auf den Wahrscheinlichkeiten basieren, mit denen bestimmte Wörter aufeinander folgen.

Die Forscher fanden auch heraus, dass LLMs dazu gebracht werden können, eine geordnete Liste von Schritten für eine bestimmte Tätigkeit zu formulieren. Wenn ein LLM beispielsweise aufgefordert wird, die Handlungen zu beschreiben, die zum Umfüllen von Murmeln erforderlich sind, kann er eine Abfolge von Handlungen vorschlagen, wie z. B. „Greifen“, „Schöpfen“, „Transportieren“ und „Ausgießen“.

„LLMs sind in der Lage, in natürlicher Sprache Anweisungen zu geben, wie jede Phase einer Aufgabe auszuführen ist. Die kontinuierliche Demonstration durch eine Person stellt diese Schritte in der realen Welt dar“, erklärt Wang. „Unser Ziel war es, diese beiden Aspekte zu kombinieren, so dass ein Roboter automatisch erkennt, an welcher Stelle einer Aufgabe er sich befindet, und in der Lage ist, selbstständig Anpassungen vorzunehmen und Fehler zu korrigieren.“

Ruhe bewahren und weitermachen

Auf der Grundlage ihres Verständnisses der Abfolge bestimmter Wörter sind die großen Sprachmodelle in der Lage, neue Textpassagen zu erstellen. Genau dies machte sich das Team zunutze, um den Roboter ein wenig gesunden Menschenverstand beizubringen. Sie entwickelten eine Methode, die einen Algorithmus verwendet, um die geografische Position eines Roboters oder visuelle Daten über seinen aktuellen Zustand einer bestimmten Handlung zuzuordnen, die durch ein LLM definiert ist.

Diese Technik, bei der sprachliche Bezeichnungen mit räumlichen oder visuellen Informationen des Roboters verknüpft werden, wird als „Grounding“ bezeichnet. Sie ermöglichte es dem Roboter, mit Hilfe der entwickelten Grounding-Klassifikatoren autonom zu agieren. Der Roboter ließ sich auch durch leichte Stöße nicht aus der Ruhe bringen, konnte Korrekturen vornehmen und seine Aufgaben fortsetzen. Er erkannte sogar, ob sich Murmeln im Löffel befanden und konnte, wenn nötig, die Aufgabe von vorne beginnen.

„Wenn der Roboter einen Fehler macht, müssen wir mit unserer Methode keine Menschen mehr um Hilfe bitten oder ihnen zeigen, wie man Fehler behebt“, sagt Wang. „Das ist sehr aufregend, denn derzeit werden große Anstrengungen unternommen, um Haushaltsroboter mit Daten zu trainieren, die von Teleoperationssystemen gesammelt wurden. Unser Algorithmus ist nun in der Lage, diese Trainingsdaten in robustes Roboterverhalten umzuwandeln, das trotz äußerer Störungen in der Lage ist, komplexe Aufgaben zu bewältigen“.

Ein Beitrag von: