Roboter erkennen menschliche Berührungen ohne externe Sensoren

DLR-Forschende haben eine neuartige Methode entwickelt, mit der Roboter menschliche Berührungen spüren können. Sie kommt ohne externe Sensoren und künstliche Haut aus.

KI und interne Sensoren sollen es möglich machen, dass Roboter auf menschliche Berührungen reagiere.

Foto: PantherMedia / Mediawhalestock (YAYMicro)

Moderne Roboter finden zunehmend Einsatz in Bereichen, die einst den Menschen vorbehalten waren: von der Industrieproduktion über die Gesundheitsversorgung bis hin zur Unterstützung im Alltag. Doch eine Herausforderung bleibt bestehen: Wie können Roboter besser und intuitiver mit dem Menschen interagieren?

Inhaltsverzeichnis

Eine Schlüsselrolle spielt dabei die Fähigkeit, menschliche Berührungen zu erkennen und angemessen darauf zu reagieren. Forschende des Deutschen Zentrums für Luft- und Raumfahrt (DLR) haben einen Ansatz entwickelt, der Robotern einen natürlichen Tastsinn verleiht, indem sie interne Sensoren mit Algorithmen des maschinellen Lernens kombinieren.

Interner Tastsinn: Die neue Dimension der Roboterwahrnehmung

Grundlage für diese Innovation ist die Nutzung vorhandener interner Kraft-Momenten-Sensoren in Roboterarmen. Diese Sensoren, die bereits zur Positionsbestimmung und Bewegungssteuerung eingesetzt werden, erfassen kleinste Veränderungen der auf den Roboter wirkenden Kraft.

Mit Hilfe von Deep-Learning-Algorithmen werden diese Sensordaten interpretiert, so dass der Roboter nicht nur Berührungen erkennen, sondern auch deren Intensität und genaue Position bestimmen kann. Dies geschieht ohne zusätzliche, teure externe Sensoren oder synthetische Häute, die bisher für solche Zwecke benötigt wurden.

Maschinelles Lernen ermöglicht Vielzahl von Anwendungen

Das DLR-Team hat diese Technologie genutzt, um einen Roboterarm mit einem Ganzkörper-Tastsinn auszustatten. Interne Sensoren in den Gelenken und an der Basis des Roboterarms ermöglichen es, physische Interaktionen präzise zu erkennen.

Durch die Anwendung von Algorithmen des maschinellen Lernens kann der Roboter sogar feine Unterschiede zwischen verschiedenen Arten von Berührungen erkennen, wie zum Beispiel das Streichen mit der Hand oder das Drücken mit dem Finger. Dies ermöglicht eine Vielzahl von Anwendungen, die von der Eingabe von Befehlen über Berührungen bis hin zum Erkennen von geschriebenen Zahlen und Buchstaben reichen.

„Der intrinsische Tastsinn, den wir in dieser Arbeit vorgeschlagen haben, kann als Grundlage für eine fortgeschrittene Kategorie der physischen Mensch-Roboter-Interaktion dienen, die bisher nicht möglich war, und ermöglicht eine Verlagerung von konventionellen Modalitäten hin zu Anpassungsfähigkeit, Flexibilität und intuitiver Handhabung“, so das Team in der Studie.

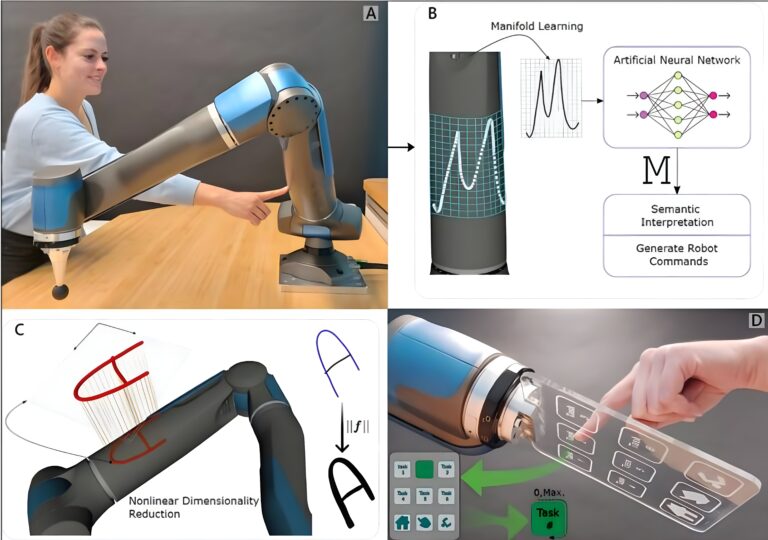

So funktioniert der intrinsische Tastsinn: Empfindliches Schreiben oder Zeichnen auf der Struktur (A) wird automatisch mit Hilfe von neuronalen Netzen interpretiert (B). Die genaue Rekonstruktion der physischen Interaktion wird mittels maschineller Lerntechniken erreicht (C). Der intrinsische Tastsinn bietet verschiedene Interaktionsmodalitäten, ohne dass explizite taktile Sensoren erforderlich sind (D).

Foto: Maged Iskandar

Fortschritte in der Mensch-Roboter-Interaktion

Die Fähigkeit, Berührungen intuitiv zu erkennen und zu interpretieren, stellt einen bedeutenden Fortschritt in der Mensch-Roboter-Interaktion dar. Herkömmliche Methoden der Mensch-Roboter-Interaktion, wie Sprach- oder visuelle Steuerung, bieten nur begrenzte Möglichkeiten der direkten physischen Interaktion.

Durch die Erweiterung der sensorischen Fähigkeiten von Robotern um den Tastsinn können sie nun in einem viel breiteren Spektrum physischer Interaktionen sicher und effizient agieren. Dies ist besonders wichtig in Umgebungen, in denen Roboter direkt mit Menschen zusammenarbeiten, wie zum Beispiel in der Pflege, der Rehabilitation oder sogar in Bildungsanwendungen.

In der industriellen Fertigung könnten solche Roboter Aufgaben übernehmen, bei denen Feinfühligkeit und Präzision gefragt sind, wie beispielsweise in der Montage von empfindlichen Elektronikkomponenten. In der Gesundheitsversorgung könnten Roboter Pflegepersonal unterstützen, indem sie Patienten berühren und so wichtige Rückmeldungen über deren körperlichen Zustand erhalten. Auch in der Rehabilitation könnten Roboter mit Tastsinn Patienten bei Übungen unterstützen und ihre Bewegungen korrigieren.

So lernen Roboter Berührungen zu erkennen

Die Implementierung eines künstlichen Tastsinns erfordert eine sorgfältige Kalibrierung und Anpassung der internen Sensoren. Kraft-Drehmoment-Sensoren messen kontinuierlich die auf den Roboter einwirkenden Kräfte. Diese Daten werden dann von Algorithmen des maschinellen Lernens verarbeitet, die darauf trainiert sind, verschiedene Berührungsmuster zu erkennen und zu unterscheiden. So können sie zum Beispiel lernen, zwischen einer leichten Berührung und einem festen Druck zu unterscheiden.

Darüber hinaus kann der Roboter mit Hilfe von neuronalen Netzen, die speziell auf die Erkennung von Zeichen und Symbolen trainiert wurden, auch visuelle Informationen interpretieren, die durch Berührung auf seine Oberfläche übertragen werden. Diese Fähigkeit eröffnet eine Vielzahl von Interaktionsmöglichkeiten, wie beispielsweise die Eingabe von Befehlen durch das Zeichnen von Symbolen auf der Roboteroberfläche.

Der von den DLR-Forschenden entwickelte Ansatz bietet mehrere entscheidende Vorteile gegenüber herkömmlichen Methoden, die auf externen Sensoren oder künstlicher Haut basieren. Zum einen entfallen die hohen Kosten und die Komplexität, die mit der Installation und Wartung solcher externen Systeme verbunden sind. Zum anderen wird die Robustheit und Zuverlässigkeit der Sensorik erhöht, da die internen Sensoren besser vor äußeren Einflüssen geschützt sind. Dies führt zu einer längeren Lebensdauer und einem geringeren Wartungsaufwand.

Ein Beitrag von: