Roboter imitiert bei komplexen Aufgaben das menschliche Verhalten

Mehrdeutige Situationen wie das Decken eines Tisches stellen Roboter vor Herausforderungen. Ein Algorithmus hilft ihnen bei mehrdeutigen Aufgaben, berichten MIT-Forscher. Er orientiert sich an der Arbeitsweise von Menschen.

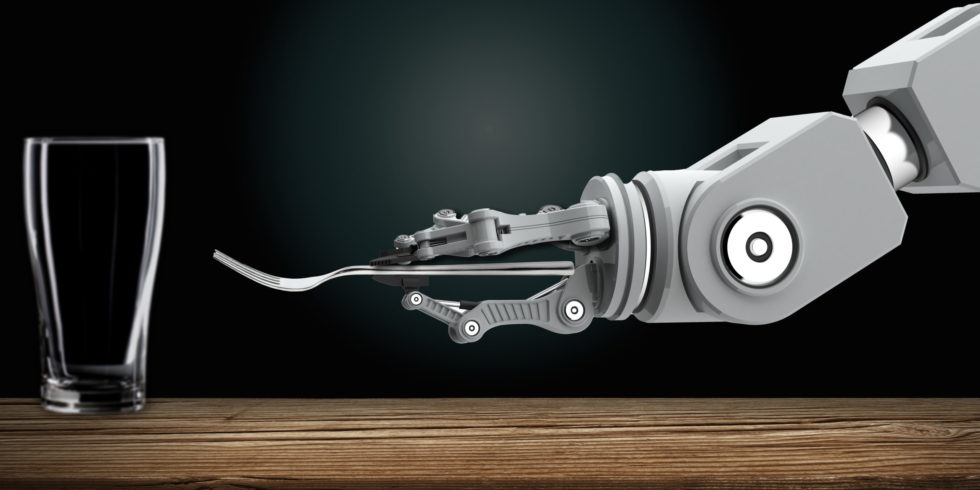

Durch die Beobachtung von Menschen lernen Roboter, komplexe Aufgaben wie das Decken eines Tisches auszuführen.

Foto: Christine Daniloff, MIT

Bislang entwickeln Ingenieure nicht nur Roboter, sondern implementieren Bewegungsabläufe in deren Software. „Unsere Vision ist es, die Programmierung in die Hände von Fachgebietsexperten zu legen, die Roboter auf intuitive Weise programmieren können, anstatt einem Ingenieur Befehle zu beschreiben, die er ihrem Code hinzufügen soll“, sagt Ankit Shah vom Massachusetts Institute (MIT) in Cambridge. „Fabrikarbeiter können einem Roboter beibringen, komplexe Montageaufgaben auszuführen. Und Haushaltsroboter können von Menschen lernen, wie man Schränke stapelt, die Spülmaschine belädt oder den Tisch deckt.“

Diesem Ziel sind MIT-Forscher jetzt ein Stück nähergekommen. Sie haben ein spezielles System entwickelt, „Planning with Uncertain Specifications“ (PUnS) genannt. Es soll Robotern die menschliche Fähigkeit näherbringen, viele, eventuell mehrdeutige Möglichkeiten der Planung abzuwägen, um ein Ziel zu erreichen. PUnS arbeitet mit Wahrscheinlichkeiten, um eine Aktion aus mehreren Optionen auszuwählen.

Für Roboter schwierig: den Tisch im Labor decken

Shahs Team entwickelte dafür eine besondere Aufgabe. Acht Objekte, nämlich ein Becher, ein Glas, ein Löffel, eine Gabel, ein Messer, ein Essteller, ein kleiner Teller und eine Schüssel, sollten auf verschiedene Art und Weise am Tisch drapiert werden.

Im ersten Schritt „beobachtete“ ein Roboter zufällig ausgewählte menschliche Handlungen beim Decken des Tischs. Dann beauftragten Forscher ihre Maschine damit, den Tisch automatisch in einer bestimmten Konfiguration zu decken, und zwar in realen Experimenten und in der Simulation.

Um erfolgreich zu sein, musste der Roboter viele mögliche Abfolgen der Handlungen berücksichtigen. Das gelang, selbst wenn die Gegenstände absichtlich entfernt, gestapelt oder versteckt worden waren. Wie Shah berichtet, sei dies bei klassischer Programmierung kaum möglich; es komme zu hohen Fehlerraten.

Mit linearer temporaler Logik Handlungen planen

Zum Hintergrund: Bei Entscheidungsaufgaben sind Ansätze des Reinforcement Learning (des bestärkenden Lernens) bekannt. Darunter versteht man Methoden des maschinellen Lernens, bei denen ein Roboter selbstständig eine Strategie erlernt, um „Belohnungen“ zu maximieren. Er bekommt zu bestimmten Zeitpunkten Rückmeldung in Form von „Strafen“ oder „Belohnungen“. Das ist aber nur möglich, falls man klare Kriterien für den Erfolg oder den Misserfolg definieren kann – also nicht generell bei Aufgaben im Haushalt. Schließlich kann man den Tisch – bei gleicher Anordnung der Gegenstände – mit unterschiedlichen Handlungen decken.

Deshalb arbeiten die Forscher mit PUnS („Planning with Uncertain Specifications“). Es basiert auf der linearen temporalen Logik (LTL, Linear Temporal Logic). In LTL können Formeln über die Zukunft von Ereignispfaden aufgestellt werden. Ein Kriterium könnte sein, dass eine Bedingung irgendwann wahr wird oder eine Bedingung wahr bleibt, bis eine andere Bedingung erfüllt wird („der Tisch wurde gedeckt, wenn acht Gegenstände nach einem Muster darauf liegen“).

Die Beobachtungen des Roboters bei 30 menschlichen Demonstrationen mit Geschirr und Besteck ergaben 25 verschiedene LTL-Formeln. Jede Formel kodierte eine etwas andere Präferenz – oder Spezifikation – für die Aufgabe. Unterschiede gibt es im Kompromiss zwischen Flexibilität und Risiko. Darüber sollen später dann die Anwender selbst entscheiden.

Geringe Fehlerrate bei Tests im Labor

Schließlich führten die Forscher 2.000 Simulationen und Experimente durch. Dabei machte ein Roboter, er sollte den Tisch in verschiedenen Varianten oder Abfolgen decken, nur sechs Fehler. Er zeigte ein ähnliches Verhalten wie Menschen bei dieser Aufgabe. Wenn beispielsweise ein Gegenstand anfangs nicht sichtbar war, beendete der Roboter das Decken an der Stelle, um andere Gegenstände zu greifen. Sobald er auf die Gabel stieß, sie war beispielsweise unter einem Teller, arbeitete er mit diesem Besteckteil weiter.

„Unser System zeigt eine hohe Flexibilität“, kommentiert Shah. „Sonst würde der Roboter stoppen, weil er ‚erwartet‘, ohne die Gabel den restlichen Tisch nicht eindecken zu können.“

Im nächsten Schritt wollen die Forscher ihr System so modifizieren, dass es Robotern hilft, unterschiedliche Signale zu verarbeiten. „Angenommen, eine Person führt einem Roboter vor, wie man einen Tisch an nur einer Stelle aufstellen kann. Die Person kann sagen, ‚mach das Gleiche für alle anderen Stellen‘ oder ‚leg das Messer hier stattdessen vor die Gabel’“, erklärt Shah. „Wir wollen Methoden entwickeln, mit denen sich das System auf natürliche Weise an diese verbalen Befehle anpassen kann, ohne dass zusätzliche Demonstrationen erforderlich sind.“

Mehr zum Thema Robotik

- Machine Learning: Industrieroboter spielt Jenga

- Kollaborative Robotik ist auf dem Vormarsch

- Flexible Sensoren und Deep Learning für weiche Roboter

Ein Beitrag von: