TU München bringt Robotern mit Hilfe von KI das Leben bei

Wie sieht der Roboter der Zukunft aus? Wie lässt sich Künstliche Intelligenz integrieren? An der TU München beschäftigen sich zahlreiche Experten aus den unterschiedlichsten Ingenieursdisziplinen mit Robotik und KI. Sie geben in diesem Beitrag Antworten auf die wichtigsten Fragen zu diesem Thema.

Wie sieht die Zukunft von Robotern aus und wie lässt sich KI integrieren?

Foto: Panthermedia.net/BiancoBlue

Künstlicher Intelligenz und Robotik gehören die Zukunft – darüber sind sich wohl alle einig. An der Entwicklung sind sehr viele Ingenieursdisziplinen beteiligt. Professor Alin Albu-Schaeffer von der Technischen Universität München (TUM) spricht sogar von einem „Zehnkampf der Ingenieurwissenschaften“. Anlässlich der Messe Automatica vom 27. bis zum 30. Juni 2023 in München zeigen Forschende der TUM, wie vielfältig die Aufgaben der Roboter-Entwicklung sind und wie es künftig damit weitergehen soll . Vereinfacht gesagt geht es darum, den Robotern mit Hilfe von KI das Leben beizubringen, damit sie irgendwann selbstständig arbeiten und Entscheidungen treffen können.

Roboter sind die Fortsetzung dessen, was die Menschen seit der Steinzeit tun

Roboter können eine beeindruckende Bandbreite an Größen aufweisen, von winzigen Tabletten bis hin zu imposanten (selbstfahrenden) Autos. Sie können menschenähnliche Gestalten haben oder als fliegende Drohnen agieren. Sie erfordern einen physischen Körper und künstliche Intelligenz, die sogenannte embodied intelligence.

„Ein Roboter“, sagt Angela Schoellig, Humboldt-Professorin an der Technischen Universität München (TUM), „ist die Fortsetzung dessen, was Menschen schon seit der Steinzeit tun – Werkzeuge entwickeln, um Aufgaben schneller oder besser auszuführen.“ An der TUM widmen sich zahlreiche renommierte Forscherinnen und Forscher aus der ganzen Welt einer Vielzahl von Herausforderungen im Bereich der Robotik.

Sollen Roboter überhaupt menschliche Züge haben?

Ob in der Gastronomie, der Pflege oder im Einzelhandel – der gegenwärtige Fachkräftemangel hat bereits spürbare Auswirkungen im Alltag. In diesem Kontext ist es naheliegend, dass Roboter einen Teil dieser Aufgaben übernehmen könnten. Ein Beispiel aus dem Restaurantbereich: Ein Roboter agiert hinter dem Tresen und beobachtet neue Kunden. Wenn jemand bestellen möchte, geht er zum entsprechenden Tisch, nimmt die Bestellung auf und leitet sie weiter. Darüber hinaus serviert er Essen und Getränke, führt angenehme Gespräche und übernimmt die Zahlungsabwicklung.

Für Professor Daniel Rixen weist das Szenario jedoch einige Schwachstellen auf: „Wollen wir wirklich einen Roboter haben, der wie ein Mensch aussieht“, fragt der Professor aus dem Lehrstuhl für angewandte Mechanik der TUM, „oder eher eine wie auch immer geartete Maschine, die die Funktionalität des Menschen ersetzt oder besser macht?“ Er macht dann auch gleich Verbesserungsvorschläge, wie es im Restaurant ablaufen könnte, wenn Roboter dort den Dienst verrichten.

So könnten Roboter in Restaurants arbeiten und aussehen

Nach Meinung von Prof. Rixen könnten im Restaurant Kameras eingesetzt werden, um die Gäste zu beobachten und zu erkennen, wenn sie einen Wunsch haben. Mit Hilfe eines integrierten Mikrofons im Tisch könnten die Kunden ihre Bestellungen aufgeben. Eine Frage, die sich außerdem stellt: „Ist es wirklich notwendig, dass Getränke und Speisen von einem humanoiden Roboter zum Tisch gebracht werden? Das könnten ja auch Roboterarme machen, die von oben den Sekt und von der Seite das Steak auf den Tisch stellen“, meint Rixen.

Bereits hier wird deutlich, dass das Erscheinungsbild eines Roboters zwar eine Rolle spielen kann, aber nicht zwingend muss. Das Spektrum reicht von Nanorobotern über Drohnen und selbstfahrenden Autos bis hin zu Roboterarmen. Das Prinzip „Form follows function“ gilt nicht nur im Design, sondern auch in der Robotik. Anwendungen, in denen der Roboter klare Aufgaben zugewiesen bekommt, lassen sich gut steuern. Ein Beispiel hierfür ist das Ernten von Paprika im Treibhaus. „Der Paprika ist egal, ob sie von einem Menschen oder Roboter gepflückt wird“, sagt Rixen. Klar ist lediglich, dass das Werkzeug der Neuzeit seinen Zweck erfüllen muss.

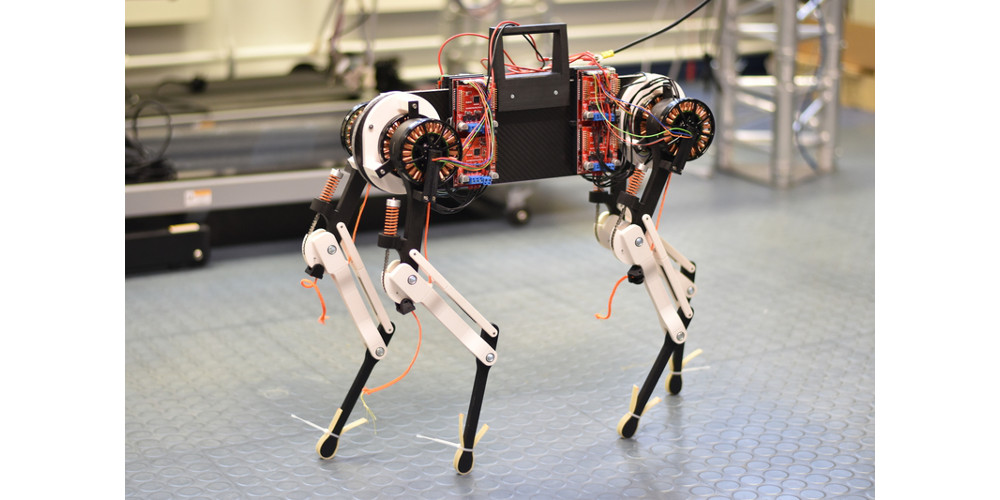

Muss ein Roboter laufen können?

Professor Rixen, der sich unter anderem mit dem humanoiden Roboter Lola beschäftigt, ist sich der Herausforderungen bewusst, die mit dem Erlernen des Laufens für einen zweibeinigen Roboter einhergehen, insbesondere auf unebenem Untergrund. Wenn zudem Gläser transportiert werden müssen, ohne dass sie überschwappen, steigen die Anforderungen an einen humanoiden Roboter im Restaurant weiter an.

„Lola wurde vor fünfzehn Jahren als steife Maschine gebaut, die sich präzise regeln lässt“, erläutert Rixen die Grundlagenforschung am Mechanik-Lehrstuhl. „Heute wissen wir, dass mehr Flexibilität und Nachgiebigkeit in den Gelenken wichtig ist. Wenn Lola stolpert, kann man weniger als sieben Mal pro Sekunde effizient nachregeln“, so der Professor des Lehrstuhls, der für alles zuständig ist, was schwingt und sich bewegt.

Komplexe Robotersteuerung

Es ist äußerst komplex, einen Roboter dazu zu bringen, laufen zu können und dabei beispielsweise ein Tablett zu tragen. Konkrete Algorithmen nutzen Bewegungsmessungen im Brustbereich, um die Motoren und Gelenke zu steuern. Dennoch bleibt der menschliche Körper, der über Jahrmillionen hinweg entwickelt wurde, nach wie vor in einer anderen Liga. Professor Rixen bezeichnet es als den „heiligen Gral“ der Robotik, die „Muskeln“ eines Roboters genauso effizient zu gestalten wie die eines Menschen.

Derzeit ist es der Maschine noch nicht möglich, Energie zu speichern und später freizusetzen, wie es beispielsweise die Achillessehne beim Menschen vermag, die einen wichtigen Impuls für das Gehen liefert. Mechanisch gesehen würde dies beispielsweise erfordern, Federn über die Gelenke einzubauen, was wiederum zu schwer kontrollierbaren Schwingungen führen kann.

Humanoide Roboter sind ein Forschungsideal

„Der humanoide Roboter ist ein Forschungsideal“, sagt Professor Alin Albu-Schaeffer, Experte auf dem Gebiet der Robotik am Deutschen Zentrum für Luft- und Raumfahrt (DLR) und an der Technischen Universität München (TUM). Er bezeichnet die Robotik als den „Zehnkampf der Ingenieurwissenschaften“, da eine Vielzahl wissenschaftlicher Disziplinen wie Mechanik, Informatik, Medizin, Elektrotechnik und Ethik bei der Entwicklung von Robotern gefragt sind. Getreu dem Motto des Physikers Richard Feynman, „Was ich nicht verstehe, kann ich nicht erschaffen“, forscht Professor Albu-Schaeffer an der technischen Umsetzung von Robotikkonzepten.

Im Fokus stehen praktische Anwendungen im Bereich der sogenannten Cobots, also kollaborierender Roboter. Dieser neue Ansatz entstand vor etwa zehn Jahren und bezieht einen Roboter ein, der sich an der Größe, Stärke und Geschwindigkeit des Menschen orientiert. „Cobot-Arme“ von Unternehmen wie Franka Emika oder Kuka erlernen komplexe Aufgaben, die später im Umfeld des Menschen eingesetzt werden sollen.

Roboter der Zukunft ist besser als der Mensch

Für Albu-Schaeffer ist klar: „Je menschlicher die Umgebung eines Roboters und je vielfältiger seine Aufgaben sein müssen, umso wichtiger ist, dass er humanoid ist.“ Und er nennt eine weitere Anforderung: „Dass er es schafft, etwas besser zu sein als der Mensch – etwa schneller zu laufen, präzisere Handgriffe zu machen oder zu fliegen“.

Unter der Leitung von Professor Sami Haddadin, dem Leiter des Munich Institute of Robotics and Machine Intelligence (MIRMI), hat der Cobot-Ansatz erhebliche Fortschritte in der künstlichen Intelligenz erfahren. Dank Bild- und Spracherkennungstechnologien sowie Echtzeittechnologien wie dem Sprachgenerator ChatGPT eröffnen sich zukünftig weitere Entwicklungen. Diese haben unter anderem ein wichtiges Ziel vor Augen: die Fähigkeit des Roboters, sich in jeder Alltagsumgebung zurechtzufinden.

Ein bedeutender Protagonist der Cobot-Technologie im MIRMI ist GARMI, ein Pflegeroboter, der im Forschungszentrum Geriatronik in Garmisch-Partenkirchen an der TUM entwickelt wurde. GARMI ist speziell für den Umgang mit pflegebedürftigen und älteren Menschen konzipiert und steht im Fokus der Forschungstätigkeiten.

Roboter müssen autonom entscheiden können

Eine entscheidende Fähigkeit von Robotern besteht darin, dass sie intelligent werden und somit autonom Entscheidungen treffen können. Professor Alin Albu-Schaeffer spricht dabei von verkörperter Intelligenz, auch als „embodied intelligence“ bekannt. Ein Experte auf dem Gebiet der künstlichen Intelligenz ist TUM-Professorin Angela Schoellig, die im Jahr 2022 von der Universität Toronto zur TUM gewechselt ist. Ihre Aufgabe besteht darin, maschinelles Lernen in Roboter zu integrieren, um ihnen zu ermöglichen, komplexere Aufgaben zu bewältigen.

Schoellig betont, dass diese Aufgaben komplexer sind als diejenigen, die von Robotern in vorprogrammierten Bewegungen erledigt werden, wie beispielsweise in der Massenfertigung in industriellen Umgebungen. Der ideale Roboter soll sich in komplexen Umgebungen bewegen können und eigenständig die Planung übernehmen. Er soll nicht von Hand programmiert werden müssen, sondern in der Lage sein, zu lernen und sich anzupassen.

Wie können Roboter selbstständig lernen?

Nehmen wir an, ein Roboter müsste eigenständig einen bestimmten Raum auf einer definierten Etage in einem Gebäude finden. „Wenn ein Programmierer nicht alle Details auf dem Weg kennt, kann er das auch nicht vorher programmieren“, betont Professorin Angela Schoellig.

Der Roboter muss also in der Lage sein, sich selbst zurechtzufinden und verschiedene Fähigkeiten zu erlernen, wie das Erkennen des Aufzugs, das Drücken des richtigen Stockwerk-Knopfes, das Wissen, welchen Flur er nehmen und welche Tür er öffnen muss. Es erfordert viele einzelne Fähigkeiten, wie das Erkennen von Objekten, das angemessene Drücken des Aufzugknopfes, das Ausweichen von Hindernissen und gegebenenfalls sogar das Nachfragen nach dem Weg. Darüber hinaus sollte der Roboter sein erworbenes Wissen auch an andere Roboter weitergeben können.

In gewisser Weise funktioniert dies ähnlich wie bei ChatGPT: „Viele haben etwas ins Internet gestellt. Das lernt nun ein neuronales Netz“, erklärt Schoellig. Allerdings ist auch klar, dass ChatGPT einem Roboter derzeit noch nicht wirklich helfen kann: „KI muss mit der physischen Welt interagieren. Es reicht nicht aus, einfach nur ‚reden‘ zu können“, relativiert auch Professor Alin Albu-Schaeffer die gegenwärtige Bedeutung von Programmen wie ChatGPT für die Robotikforschung.

Eine besondere Herausforderung für die Robotik liegt zudem in der Vielfalt der Systeme. Wenn Roboter unterschiedliche Machine-Learning-Modelle oder Sensoren verwenden, gestaltet sich die Übertragung von Erkenntnissen und die Bereitstellung für andere Roboter über die Cloud derzeit noch schwierig.

Nicht auf das Aussehen, sondern auf den Zweck kommt es an

Bislang wurden viele einzelne KI-basierte Fähigkeiten erforscht, allerdings mit spezifischen Anwendungszwecken. Professorin Angela Schoellig hat beispielsweise Flugroboter im Tagebau eingesetzt, um die Größe der Steine nach Sprengungen kontinuierlich zu messen und später die Sprengsätze zu optimieren. Darüber hinaus wurde ein Roboter namens „The Thing“ entwickelt, der in der Lage ist, Bälle zu fangen oder Gegenstände auf einem Tablett auszubalancieren. Ein anderer Roboter kann Produkte aus einem Korb nehmen und sie in der richtigen Ausrichtung auf ein Fließband legen oder direkt einbauen.

In Zukunft wird es weniger darum gehen, ob ein Roboter im Restaurant wie ein Mensch aussieht, sich bewegt und spricht, sondern vielmehr darum, ob er einen sinnvollen Beitrag leistet, um einen konkreten Zweck zu erfüllen. Es geht darum, ob der Roboter einen praktischen Nutzen hat und effektiv dazu beiträgt, bestimmte Aufgaben zu erledigen.

Ein Beitrag von: