Innovativer Roboterhund springt, klettert oder kriecht wie nie zuvor

Ein neuer Roboterhund der Stanford University kann zwar keinen neuen Tricks, dank eines innovativen Algorithmus kann er jedoch springen, klettern oder kriechen wie nie zuvor. Eines Tages könnte er Ersthelfer bei Erdbeben, Bränden oder Überschwemmungen sein.

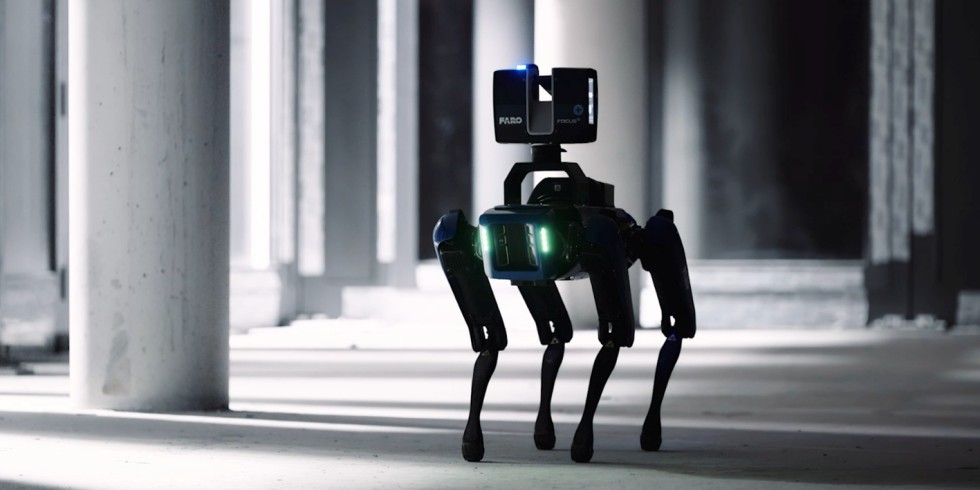

Der Roboterhund absolviert einen Parkour dank neuem Algorithmus so gut wie nie zuvor.

Foto: Shanghai Qi Zhi Institute/Stanford University

KI-Forscher der Stanford-University haben mit einer vereinfachten Technik des maschinellen Lernens einen Roboterhund geschaffen, der seinem lebenden Vorbild so nahe kommt wie noch nie zuvor. Ziel ist es, dass er eines Tages als Rettungshund in Erdbeben- oder Überschwemmungsgebiete oder brennende Häuser geschickt wird, um dort erste Hilfe zu leisten. Mit einem Computersichtgerät ausgestattet, könnte der batteriebetriebene Vierbeiner Hindernisse einschätzen und mit hundeähnlicher Gewandtheit überwinden.

Neuer Algorithmus macht den Roboterhunden Beine

Damit der Roboterhund eines Tages Leben retten kann, haben KI-Forscher der Stanford University und des Shanghai Qi Zhi Institute einen neuen Algorithmus entwickelt. Er soll den Robodogs dabei helfen, hohe Objekte zu erklimmen, über Abgründe zu springen, unter Schwellen hindurchzukriechen und sich durch Spalten zu zwängen. Ist die Aufgabe gemeistert, sollen sie sofort zur nächsten Herausforderung flüchten. Der Algorithmus ist hierbei das Gehirn des Roboterhundes.

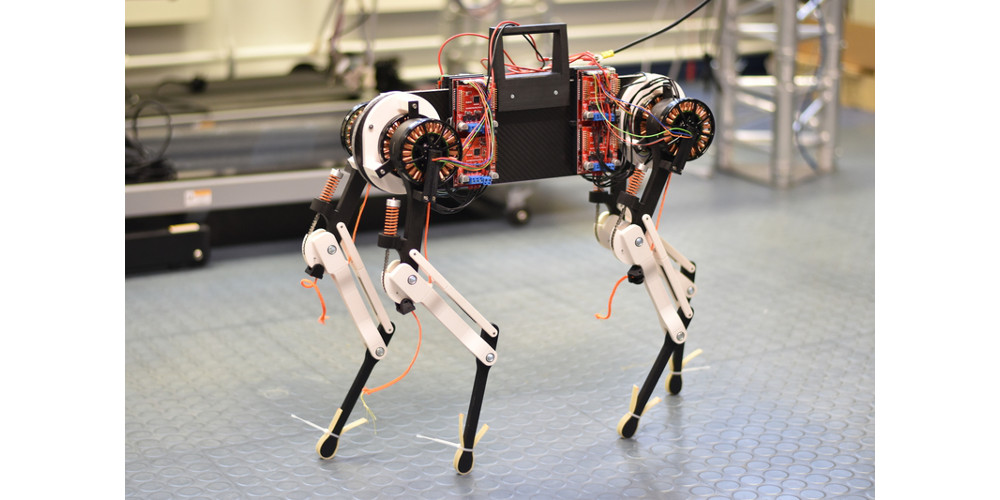

„Die Autonomie und die Bandbreite der komplexen Fähigkeiten, die unser vierbeiniger Roboter erlernt hat, sind beeindruckend“, sagt Chelsea Finn, Assistenzprofessorin für Informatik und Hauptautorin eines neuen, von Experten begutachteten Papiers, das den Ansatz des Teams ankündigt und auf der kommenden Conference on Robot Learning vorgestellt wird. „Und wir haben ihn mit kostengünstigen, handelsüblichen Robotern entwickelt – eigentlich mit zwei verschiedenen handelsüblichen Robotern.“

Autonomie als entscheidender Fortschritt

Der entscheidende Fortschritt besteht laut Meinung des Forschungsteams darin, dass ihr Roboterhund autonom unterwegs ist. So sei er in der Lage, physische Herausforderungen einzuschätzen und sich eine Reihe von Beweglichkeitsfähigkeiten vorzustellen und dann auszuführen. Dabei sei ihr Robodog nicht der erste, der einen solchen „Parkour“ absolvieren könne, aber er sei der erste, der Selbstständigkeit mit einer breiten Palette von Fähigkeiten kombiniere.

„Wir kombinieren Wahrnehmung und Steuerung, indem wir Bilder von einer am Roboter angebrachten Tiefenkamera und maschinelles Lernen verwenden, um all diese Eingaben zu verarbeiten und die Beine zu bewegen, um über, unter und um Hindernisse herumzukommen“, so Zipeng Fu, Doktorandin in Finns Labor und Erstautorin der Studie, zusammen mit Ziwen Zhuang vom Shanghai Qi Zhi Institute.

Fu weiter: „Unsere Roboter haben sowohl Vision als auch Autonomie – die sportliche Intelligenz, um eine Herausforderung einzuschätzen und Parkour-Fähigkeiten je nach den Anforderungen des Augenblicks selbst auszuwählen und auszuführen.“

Unterschied zu bestehenden Lernmethoden

Bestehende Lernmethoden für Roboterhunde sind oft komplex und auf bestimmte Umgebungen zugeschnitten. Daher lassen sie sich schlecht auf neue Umgebungen übertragen. Bei anderen Ansätzen lernen die Roboterhunde anhand von Daten aus der realen Welt. Diese Methoden sind jedoch rechenintensiv und die Hunde haben eine eingeschränkte Bewegungspalette.

Die neue Open-Source-Anwendung des Forschungsteams verwendet ein einfaches Belohnungssystem und keine realen Referenzdaten. Sie erreicht damit eine breite Palette von Fähigkeiten und ist schneller als bestehende Methoden, schreiben die Autoren in der Studie.

Algorithmus lernt, wie er am besten an neue Aufgaben herangeht

Um Roboterhunden das Parkour-Können beizubringen, haben Forscher einen neuen Algorithmus entwickelt. Dieser Algorithmus wurde zunächst an einem Computermodell getestet und dann auf zwei reale Roboterhunde übertragen.

Im nächsten Schritt wurden die Roboterhunde in einem Prozess namens Verstärkungslernen trainiert. Dabei versuchten sie sich auf jede erdenkliche Weise vorwärts zu bewegen und wurden je nach Erfolg belohnt. So lernte der Algorithmus schließlich, wie er den Hunden das Parkour-Können am besten beibringt.

Der neue Algorithmus ist besonders effektiv, weil er ein einfaches Belohnungssystem verwendet. Dies macht ihn nicht nur schneller, sondern auch einfacher zu implementieren als bestehende Methoden. „Es ist eigentlich ziemlich einfach“, sagt Finn. „Wir richten uns hauptsächlich danach, wie weit sich der Roboter vorwärts bewegt und wie viel Kraft er dafür aufwendet. Mit der Zeit erlernt der Roboter komplexere motorische Fähigkeiten, die es ihm ermöglichen, voranzukommen.“

Tests in der realen Welt

Den neuen Algorithmus testeten die Forschenden abschließend mit echten Roboterhunden in der realen Welt. Ziel war es, ihre Agilität in besonders schwierigen Umgebungen zu demonstrieren. Zum Einsatz kamen hierbei lediglich handelsübliche Computer, visuelle Sensoren und Energiesysteme der Robodogs.

Die Roboterhunde zeigten, dass sie auf Hindernisse klettern konnten, die eineinhalb Mal so groß wie sie waren. Sie konnten zudem über Lücken springen, die mehr als das Anderthalbfache ihrer Länge betrugen. Zudem krochen sie unter Hindernissen hindurch, die lediglich drei Viertel ihrer Höhe betrugen. Nicht zuletzt konnten sich die Roboterhunde neigen, um durch Schlitze zu kommen, die dünner als ihre Breite war.

In Zukunft plant das Forschungsteam, den Algorithmus zu verbessern, indem es reale Daten zu den simulierten Umgebungen hinzufügt. Dies würde den Algorithmus noch autonomer machen und ihm ermöglichen, in der realen Welt noch schwierigere Aufgaben zu bewältigen. Dabei möchte es die Fortschritte in der 3D-Vision und -Grafik nutzen.

Ein Beitrag von: