KI-Tools und der Schutz vor der Privatsphäre

KI-Tools sammeln jede Menge privater Daten. Ein neues mathematisches Modell soll für mehr Sicherheit sorgen. Erfahren Sie außerdem, wie Sie sich generell schützen.

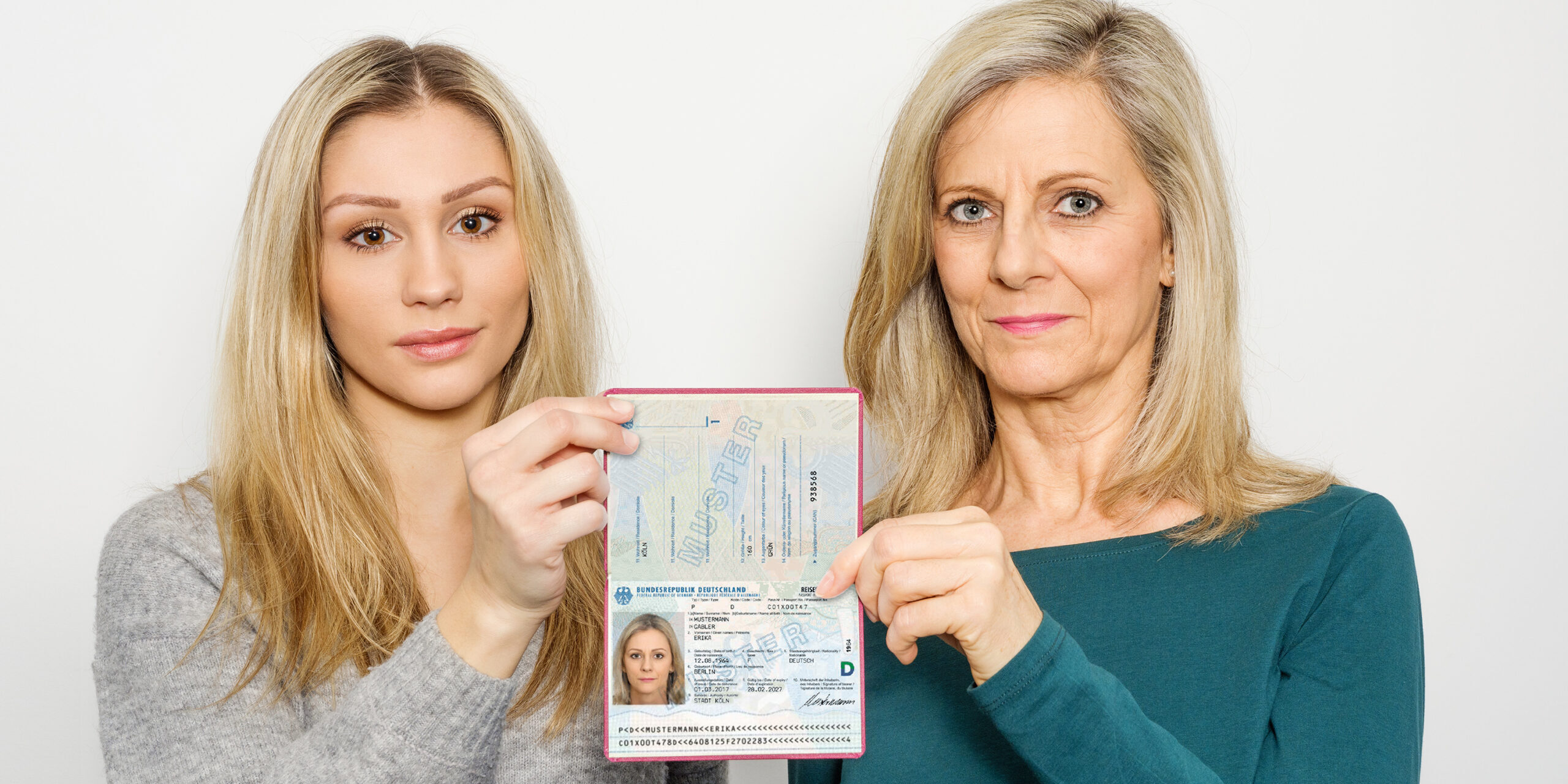

Das Nutzen mit KI-Tools ist immer auch mit dem Thema Datensicherheit verbunden. Wie lässt sich die Privatsphäre bewahren?

Foto: PantherMedia / yokhanomwan@gmail.com

Künstliche Intelligenz (KI) hat in den letzten Jahren rasante Fortschritte gemacht. Ob bei Sprachmodellen wie ChatGPT oder Bildgeneratoren – KI wird immer mehr in den Alltag integriert. Doch je leistungsfähiger die Tools werden, desto größer werden auch die Herausforderungen für den Schutz der Privatsphäre. Viele KI-Tools sammeln und analysieren riesige Datenmengen, um ihre Leistung zu verbessern. Doch was passiert mit diesen Daten, und wie können Sie Ihre sensiblen Informationen schützen? Schauen wir uns jedoch zunächst eine aktuelle Forschung zum Thema an.

Inhaltsverzeichnis

Neues mathematisches Modell zum Schutz der Privatsphäre

So schön und arbeitssparend KI-Tools auch sein mögen, bergen sie doch einige Risiken für die Privatsphäre. Forschende vom Oxford Internet Institute, dem Imperial College London und der UCLouvain präsentierten Anfang Januar 2025 ein neues mathematisches Modell, das den Schutz personenbezogener Daten revolutionieren könnte.

Zum ersten Mal bietet das Modell eine solide Grundlage, um Identifizierungstechniken in großen Datensätzen zu bewerten. Besonders im Fokus steht das sogenannte „Browser-Fingerprinting“. Dabei können Nutzer anhand von Informationen wie Zeitzone oder Browsereinstellungen identifiziert werden. Diese Methode wird häufig von Werbeanbietern genutzt, um gezielte Werbung auszuspielen.

Dr. Luc Rocher, Hauptautor der Studie und Senior Research Fellow am Oxford Internet Institute, erklärte: „Wir sehen unsere Methode als neuen Ansatz, um das Risiko einer erneuten Identifizierung bei der Datenfreigabe zu bewerten, aber auch um moderne Identifizierungstechniken in kritischen, risikoreichen Umgebungen zu evaluieren. In Bereichen wie Krankenhäusern, humanitärer Hilfe oder Grenzkontrollen steht unglaublich viel auf dem Spiel.“

Wie funktioniert das Modell?

Das Modell basiert auf der Bayesschen Statistik. Es analysiert, wie leicht einzelne Personen identifiziert werden können, und skaliert diese Ergebnisse auf größere Bevölkerungsgruppen. Dabei erreicht es eine bis zu zehnmal höhere Genauigkeit als bisherige Ansätze. Diese Präzision ermöglicht es, Schwachstellen von Identifizierungstechniken aufzudecken und zu bewerten, warum einige Methoden in kontrollierten Tests gut funktionieren, in der Praxis jedoch fehlerhaft sind.

Yves-Alexandre de Montjoye vom Imperial College London, Mitautor der Studie, erklärte: „Unser neues Skalierungsgesetz bietet erstmals ein prinzipienbasiertes mathematisches Modell, mit dem sich die Leistung von Identifizierungstechniken im großen Maßstab bewerten lässt.“

Anwendungsbereiche

Die Anwendungsmöglichkeiten des Modells sind vielseitig. Es kann beispielsweise:

- die Genauigkeit von KI-gestützten Identifizierungstechniken in der Strafverfolgung bewerten,

- Schwachstellen in Datenschutzsystemen aufdecken und

- Unternehmen helfen, Datenschutzgesetze einzuhalten.

Ein zentrales Ziel ist es, Organisationen dabei zu unterstützen, ein Gleichgewicht zwischen der Nutzung von KI und dem Schutz sensibler Daten zu finden. Dadurch könnten alltägliche Interaktionen sicherer gestaltet werden.

Bedeutung für den Datenschutz

Die Ergebnisse kommen zu einem günstigen Zeitpunkt. Immer mehr KI-Tools können Personen anhand von Merkmalen wie Stimme, Gesicht oder Augen identifizieren. Diese Entwicklungen stellen den Datenschutz vor neue Herausforderungen. Das neue Modell bietet die Möglichkeit, Identifizierungstechniken vor ihrer breiten Anwendung zu testen und zu verbessern.

Dr. Rocher betonte: „Diese Arbeit ist ein entscheidender Schritt in Richtung prinzipientreuer Methoden, um die Risiken fortschrittlicher KI-Techniken zu bewerten.“ Die Forscher hoffen, dass ihre Erkenntnisse nicht nur in der Forschung, sondern auch in der Praxis Anwendung finden.

Hier geht es zur Originalpublikation

So schützen Sie sich vor ungewolltem Datensammeln

Um sich vor ungewolltem Datensammeln durch KI-Tools zu schützen, sollten Sie die Datenschutzoptionen der jeweiligen Anwendungen nutzen. Viele Anbieter bieten die Möglichkeit, die Datenweitergabe zu reduzieren oder zu deaktivieren. Hier sind konkrete Schritte:

- ChatGPT: Gehen Sie in die Einstellungen und deaktivieren Sie unter „Datenkontrollen“ die Option „Das Modell für alle verbessern“. Damit verhindern Sie, dass Ihre Eingaben für das Training des Modells verwendet werden.

- Google Gemini: Unter „Gemini-Apps-Aktivitäten“ können Sie das Sammeln von Nutzerdaten deaktivieren und zusätzlich festlegen, dass bestehende Daten nach einer bestimmten Zeit automatisch gelöscht werden.

- Meta AI: Nutzen Sie das Privacy Center von Facebook oder Instagram, um Ihre Einstellungen zu optimieren. Dort können Sie Anfragen zur Datenverarbeitung gezielt stellen.

Für Microsoft Copilot und Claude gibt es keine direkte Option, die Datensammlung zu deaktivieren. Während Claude keine Daten für Trainingszwecke nutzt, anonymisiert Microsoft nach eigenen Angaben die gesammelten Informationen. Trotzdem bleibt ein gewisses Restrisiko bestehen.

Zusätzlich sollten Sie die folgenden allgemeinen Tipps beachten:

- Vermeiden Sie die Eingabe sensibler Daten: Teilen Sie keine Passwörter, Finanzinformationen oder persönliche Details mit KI-Tools.

- Prüfen Sie die Datenschutzrichtlinien: Informieren Sie sich darüber, wie Ihre Daten genutzt werden.

- Regelmäßige Updates: Stellen Sie sicher, dass Sie stets die neueste Version der Software verwenden, da diese oft verbesserte Datenschutzfunktionen bietet.

Lokale KI-Tools: Ein Weg zur Datenhoheit

Eine vielversprechende Alternative zu cloudbasierten KI-Tools sind lokal installierte Anwendungen. Diese Tools laufen auf Ihrem eigenen Rechner und benötigen keine Verbindung zu externen Servern. Dadurch behalten Sie die volle Kontrolle über Ihre Daten.

Vorteile lokaler Tools

- Volle Kontrolle: Alle Eingaben und Ergebnisse bleiben auf Ihrem Gerät. Es erfolgt keine Weiterleitung an Drittanbieter.

- Unabhängigkeit von Lizenzen: Sie können unbegrenzt viele Texte, Bilder oder andere Inhalte generieren, ohne auf kostenpflichtige Abonnements angewiesen zu sein.

- Erhöhte Sicherheit: Da keine Internetverbindung erforderlich ist, bleibt das Risiko eines Datenlecks minimal.

Programme wie LM Studio oder GPT4All bieten benutzerfreundliche Oberflächen und leistungsstarke Sprachmodelle. Nach der Installation können Sie verschiedene Modelle herunterladen und lokal nutzen. Diese Tools sind besonders für Unternehmen oder Bildungseinrichtungen interessant, die sensible Informationen verarbeiten.

Auch die Bildgenerierung ist lokal möglich. Tools wie Stable Diffusion web UI ermöglichen es, Bilder offline zu erstellen und zu bearbeiten. Ein weiteres nützliches Tool ist Upscayl, das die Auflösung von Bildern erheblich verbessern kann. Beide Programme benötigen keine Internetverbindung und sind ideal für Anwender, die ihre Daten nicht aus der Hand geben möchten.

Ein Beitrag von: