Neue Trainingsmethode: Roboter lernt in unter zwei Minuten

Das Crowdsourcing-Feedback ist als Trainingsmethode für Roboter bereits bekannt. Forschende aus den USA haben nun einen neuen Ansatz für verstärktes Lernen entwickelt und dafür die Art und Weise der Belohnung verändert. Sie nutzen auch Daten von Laien – und sogar fehlerhafte Informationen.

Forschende haben eine neue Trainingsmethode entwickelt. Das Ergebnis: Der Roboter lernt schneller, auch mit fehlerhaften Daten.

Foto: panthermedia.net/phonlamai

Roboter sind in dem, was sie tun und erledigen, nur so gut, wie sie es im Training zuvor gelernt haben. Und darauf hat der Mensch den größten Einfluss. Denn er ist es, der die Art und Weise des Trainings sowie dessen Inhalte festlegt. In einem Punkt unterscheidet sich das Training eines Roboters nicht von dem des menschlichen Lernens: bei der Belohnung. Auch ein Roboter benötigt eine solche. Forschende des MIT, der Harvard University und der University of Washington haben deshalb einen neuen Ansatz für verstärktes Lernen entwickelt, mit Fokus auf die Belohnung.

Roboterhand mit Knochen, Sehnen und Bändern aus dem 3D-Drucker

Normalerweise setzt man ein sogenanntes Crowdsourcing-Feedback ein. Es stammt von zahlreichen fachkundigen Benutzerinnen und Benutzern, wird gesammelt und dann beim Training verwendet. Der neue Ansatz nutzt nun Feedback von Benutzerinnen und Benutzern, die Laien sind. Zwar können Crowdsourcing-Daten durchaus viele Fehler enthalten, zählen damit also zu den sogenannten verrauschten Daten, doch sie ermöglichen trotzdem ein schnelleres Lernen. Gleichzeitig kann mit diesem Ansatz auch die asynchrone Erfassung von Feedback genutzt werden. Auf diese Art und Weise tragen fachkundige Nutzerinnen und Nutzer weltweit zum Training bei.

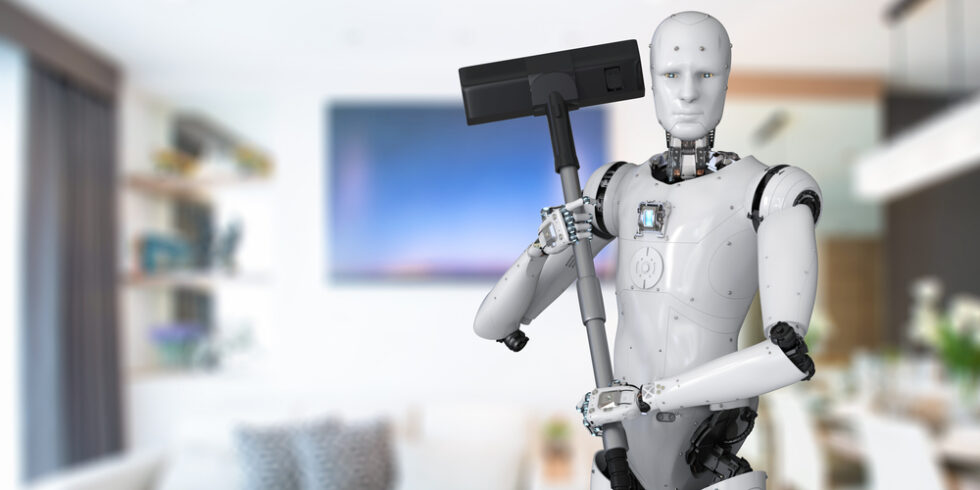

Laien trainieren Roboter – mit Erfolg

„Unsere Arbeit schlägt eine Möglichkeit vor, das Lernen von Robotern zu skalieren, indem wir das Design der Belohnungsfunktion per Crowdsourcing entwickeln und es Laien ermöglichen, nützliches Feedback zu geben“, sagt Pulkit Agrawal, Assistenzprofessor am MIT Department of Electrical Engineering an Computer Sciences (EECS), der auch das Improbable AI Lab am MIT Computer Science and Artificial Intelligence Laboratory (CSAIL) leitet. Von ihrer neuen Methode versprechen die Forschenden sich vor allem eines: Der Roboter soll damit schneller lernen, bestimmte Aufgaben im Haus einer Benutzerin oder eines Benutzers auszuführen, ohne dass man ihm physische Beispiele für jede Aufgaben zeigen muss. Vielmehr könne der Roboter dies selbstständig in Erfahrung bringen – geleitet vom Crowdsourcing-Feedback von Laien.

Der Unterschied der neuen Belohnungsmethode zeige sich vor allem darin, dass man dem Roboter nicht genau die Aufgabe antrainieren müsse, sondern er sie sich selbst erschließe. Darüber hinaus soll der Roboter auch in der Lage sein, selbstständig herauszufinden, was ihm beim besseren Lernen helfe.

Robotertraining in zwei Prozessteile gegliedert

Und so funktioniert das Training: Der Roboter soll eine Kühlschranktür öffnen können. Dafür erhält er zwei Fotos, auf denen eine Schranktür und eine Mikrowelle geöffnet werden. Nun stellt man ihm die Frage, welcher der abgebildeten Zustände näher am gewünschten Ziel liegt. Da der Roboter die Belohnungsfunktion ernst nimmt und sie versuchen würde, perfekt zu erfüllen, nutzen die Forschenden sie nun, um ihm mitzuteilen, welche Bereiche er erkunden soll. Dafür haben sie den Prozess in zwei Teile gegliedert. Beide werden jeweils von einem eigenen Algorithmus gesteuert. Die Forschenden bezeichnen dies als neue Reinforcement-Learning-Methode HuGE (Human Guided Exploration).

Auf der einen Seite wird der Zielauswahlalgorithmus kontinuierlich mit menschlichem Crowdsourcing-Feedback aktualisiert. Somit dient das Feedback nicht als Belohnung, sondern als Orientierungshilfe bei der Erkundung. Man kann sich das ähnlich wie eine Schnitzeljagd vorstellen. Dabei werden ja auch auf dem Weg zum Ziel Hinweise hinterlassen. Auf der anderen Seite begibt sich der Roboter selbstständig auf Erkundungstour, wobei er vom sogenannten Zielselektor geleitet wird. Während der Erkundung sammelt er Bilder oder Videos von Aktionen, die ihm beim Lernen helfen. Das Ergebnis: Das Feedback kann selten und asynchron gesammelt werden.

Roboter lernen in weniger als zwei Minuten

In ersten Tests mussten Roboter eine Reihe simulierter und realer Aufgaben erledigen. In der Simulation waren es Aufgaben mit langen Aktionssequenzen. Ein Beispiel: Blöcke in einer bestimmten Reihenfolge stapeln oder aus einem großen Labyrinth herausnavigieren. Im realen Test sollten die Roboter den Buchstaben „U“ zeichnen, Objekte auswählen und sie an vorgegebenen Orten platzieren. Für die Tests sammelten sie Daten von 109 Laien in 13 verschiedenen Sprachen auf drei Kontinenten.

Insgesamt waren die Forschenden sehr zufrieden mit den Ergebnissen. Die Roboter lernen mithilfe der neuen Methode schneller und erreichen dementsprechend effizienter das Ziel. Darüber hinaus ergäben sich auf Basis von Crowdsourcing-Daten von Laien bessere Leistungen als durch das Training mit synthetischen Daten, welche die Forschenden erstellt hatten. In weniger als zwei Minuten sei für Laien ein Training eines Roboters möglich. Das mache es eben möglich, diese Methode zu skalieren und der Roboter könne völlig autonom lernen, ohne dass menschliche Resets erforderlich seien.

Ein Beitrag von: