Wie synthetische Daten die KI in der Produktion trainieren

Wer Produktionsprozesse mit KI-Hilfe verbessern möchte, braucht viele Daten. Synthetische Daten könnten vieles einfacher machen.

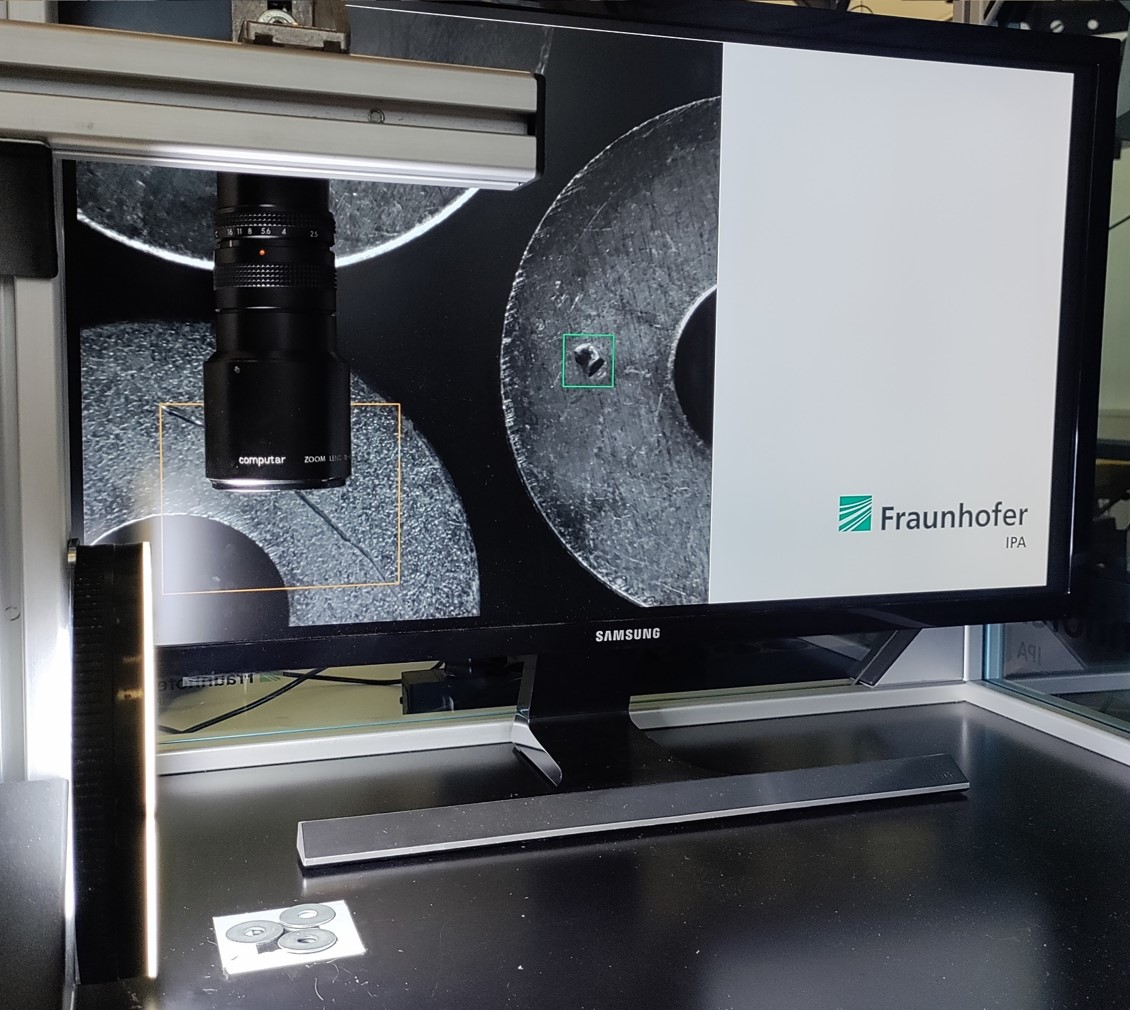

Synthetische Daten werden bereits zum Training von industriellen Bilderkennungssystemen für die Qualitätssischerung genutzt. Weitere Anwendungsbereiche wie die Progrose von Maschinenausfällen erfordern die Analyse von weiteren Parametern wie Temperatur und Schwingungen.

Foto: PantherMedia / firefox

Inhaltsverzeichnis

- Synthetische Daten: Trainingsdaten für KI digital generieren

- Der Mensch beurteilt die Ergebnisse der KI

- Synthetische Daten per Rendering oder generativer KI erzeugen?

- Technischer Aufwand zum Erstellen synthetischer Daten

- Welchen Sicherheitsanforderungen unterliegt der KI-Einsatz?

- Abhängigkeit von Nvidia und anderen großen KI-Modellen

- VDI-Konferenz „KI in der Produktion“ gibt vielfältige Einblicke

- Einblicke in die Forschung zur Verwendung generativer KI-Modelle

Niemand möchte erst einmal Ausschuss oder Maschinenausfälle produzieren müssen, um damit dann KI-Modelle zu trainieren. Denn die Modelle sollen Schäden in der Produktion ja letztlich verhindern. Womit können die Algorithmen aber dann trainiert werden? Der Schlüssel dazu sind synthetische Daten.

„Zum Training von KI muss man normalerweise schon einen Datenvorrat haben. Entweder hat man den aus Produktionsprozessen bereits aufgezeichnet und irgendwo abgespeichert oder man muss ihn erzeugen“, bringt es Marco Huber auf den Punkt. Der wissenschaftliche Direktor für Digitalisierung und KI am Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA in Stuttgart weiß aber auch, dass es oft lange dauern kann, bis genug Daten zum Training der KI zur Verfügung stehen.

Synthetische Daten: Trainingsdaten für KI digital generieren

Inzwischen lassen sich Trainingsdaten dafür auch digital generieren, bevor sie überhaupt in einer realen Produktionsumgebung erfasst werden können. Experten sprechen dann von „synthetischen Daten“. Gerade in der Qualitätssicherung und in der Robotik werden diese bereits zum KI-Training verwendet. Üblicherweise erzeugten Kamerasysteme in der industriellen Bildverarbeitung permanent Daten. Mit Computersystemen lassen sich hier laut Huber alternativ per Rendering-Verfahren unterschiedliche Bauteiloberflächen und Beleuchtungssituationen realitätsnah simulieren und somit synthetische Daten generieren.

Auch bei Robotern werden laut dem Fraunhofer-Forscher durch die Fortschritte in der Simulation immer mehr Daten per Computer generiert und für das KI-Training der Robotersteuerung genutzt. Noch nicht ganz so weit sei die Forschung bei der Wartung von Maschinen und Anlagen. Statt Textinformationen oder Bilder müssen dann Kräfte, Momente, Temperaturen oder Schwingungen bewertet werden.

„Das Arbeiten mit synthetischen Daten bietet einen wesentlichen Vorteil im Vergleich zu realen Daten“, sagt Marco Huber. Er ist wissenschaftlicher Direktor für Digitalisierung und KI am Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA in Stuttgart.

Foto: © Fraunhofer IPA/

Foto: Phil Aznar, Philipp Hüttenhein

„Gerade in der Produktion hat man sehr hochfrequente Daten, die mit einer hohen Taktung aufgenommen werden. Schwingungsdaten sind beispielsweise für die Wartung wichtig“, berichtet Huber. Die Informationen würden in Zeitreihen über Wochen und Monate aufgenommen. „Solche Daten zu simulieren, würde den Aufwand erheblich reduzieren“, zeigt sich der IPA-Professor überzeugt. Denn: „Je nachdem, was für eine Komponente ich betrachte, kann es sehr lange dauern, bis sie ausfällt.“ Es wäre also viel besser, den Verschleißprozess zu modellieren und damit eine KI für die vorausschauende Wartung zu trainieren. Doch das sind noch Zukunftspläne.

Der Mensch beurteilt die Ergebnisse der KI

„Das Arbeiten mit synthetischen Daten bietet einen wesentlichen Vorteil im Vergleich zu realen Daten“, erklärt der Wissenschaftler. Denn für das Training einer KI zur Qualitätsprüfung sind sogenannte gelabelte bzw. annotierte Daten erforderlich. Huber beschreibt das so: „Wenn auf einem Bild ein Defekt zu erkennen ist, muss der Mensch für das System die Stelle markieren und möglichst auch die Defektart beschreiben.“ Entsprechend zeitaufwendig sei dieser Teil der Arbeit im Normalfall, der bei synthetischen Daten entfällt.

Außerdem gibt es laut dem Wissenschaftler Unschärfen, ab wann ein Fehler wirklich als relevant eingestuft wird. Huber sagt: „Wenn ich zwei unterschiedliche Annotatoren habe, können die zu unterschiedlichen Ergebnissen kommen.“ Er weiß aber auch: Wurden die Kriterien einmal festgelegt und der Erstellungsprozess für die Daten automatisiert, dann weiß das System, wo welche Fehler liegen. Damit entfalle der Aufwand des nachträglichen Annotierens und Markierens.

Synthetische Daten per Rendering oder generativer KI erzeugen?

Überall dort, wo bereits Computermodelle in Form von CAD-Daten vorhanden sind, wie bei der Qualitätskontrolle von Bauteilen, bietet das Rendering zur Erzeugung synthetischer Daten laut Huber große Vorteile. Durch die Bildsynthese entstehen realitätsnahe Bilder, wie man sie aus Videospielen oder Animationsfilmen kennt. Der initiale Aufwand beim Erstellen von Trainingsdaten mittels Rendering sei aber höher als bei der Verwendung generativer KI. „Beim Rendering muss zunächst die Bildszene am Rechner modelliert werden. Bei einer generativen KI entfällt dieser Modellierungsaufwand und ich kann direkt Bilder erzeugen. Bekannt geworden ist diese Technik durch reine Fantasiebilder, wie den Papst in der Daunenjacke. Das geht auch mit Defektbildern. Dann habe ich aber weniger Kontrolle darüber, wie der Defekt aussieht und wo er sich befindet“, merkt er an.

Für Huber gilt es deshalb, die Vor- und Nachteile gegeneinander abzuwägen. „Generative KI macht z. B. dann Sinn, wenn es kein CAD-Modell gibt, beispielsweise bei Schüttgut oder im medizinischen Bereich wie bei der Analyse von Blutbildern in der Krebsdiagnostik.“ Gegenüber dem Einsatz von synthetischen Daten, ob nun per Rendering oder durch generative KI erzeugt, könne das Anlernen einer KI mit realen Bildern eines einfachen Produktes, z. B. einer Lochscheibe, zwischen Faktor 20 bis 40 länger dauern. „Sie müssen ja erst einmal eine relevante Anzahl an Fehlern erzeugen und diese dann manuell annotieren“, sagt der Experte.

Er fügt aber hinzu: „Auf der anderen Seite führen reale Daten in den meisten Fällen zu besseren Ergebnissen.“ Das hätten auch Untersuchungen am Fraunhofer IPA ergeben. Dabei wurden Trainingsergebnisse verglichen, die mal mit realen Eingangsdaten, mal mit synthetischen Daten und mal mit einer Mischform aus beiden erzeugt wurden. Huber glaubt aber auch, dass durch technische Weiterentwicklungen die Simulation den Abstand künftig verringern werde.

Technischer Aufwand zum Erstellen synthetischer Daten

Der technische Aufwand zum Erzeugen synthetischer Daten auf Basis eines vorhandenen CAD-Modells für den Rendering-Weg ist laut Huber überschaubar. „Die Lösungen sind dafür ausgelegt, dass sie auf normalen Workstations laufen.“ Bei generativen KI-Modellen sei das jedoch anders. „Die müssen für die spezielle Anwendung trainiert werden und erfordern leistungsfähige Grafikkarten. Je nach Komplexität der Modelle fallen dafür vier- bis fünfstellige Eurobeträge für die Hardware an“, rechnet der Experte vor.

Simulation: Am Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA in Stuttgart wird in diesem Szenario die Prüfung von Lochscheiben per KI-Modell erprobt.

Foto: © Fraunhofer IPA/

Foto: Frederik Seiler

Welchen Sicherheitsanforderungen unterliegt der KI-Einsatz?

Während optische Mängel an einer Lochscheibe nicht unbedingt zu einem Schaden führen, ist das bei einem Mangel im Roboterprogramm anders. Aber wie kann die funktionale Sicherheit dann sichergestellt werden? „Das ist noch nicht ausdefiniert“, räumt der Experte vom Fraunhofer IPA für solche Hochsicherheitsanwendungen ein. „Für die funktionale Sicherheit ist die Maschinenverordnung zuständig und da gibt es derzeit noch einen Graubereich beim KI-Einsatz“, berichtet er. Die KI-Verordnung sei zwar schon verabschiedet, es gebe aber noch eine große Unsicherheit. „Welche Nachweise zu erbringen sind und wie genau die Prüfverfahren ablaufen, wird wohl erst in den nächsten zwei bis drei Jahren konkreter“, vermutet er.

Erste Anwendungen wurden aber laut Huber bereits zertifiziert, beispielsweise für die Überwachung von Tischkreissägen. „Da schaut eine KI-überwachte Kamera auf das Sägeblatt. Sobald ein Finger sich nähert, schaltet sie die Säge geregelt aus oder senkt das Sägeblatt ab. Das ist eine Alternative zu induktiven Lösungen, bei der das Sägeblatt nach der harten Notbremsung nicht mehr zu gebrauchen ist“, so Huber.

Abhängigkeit von Nvidia und anderen großen KI-Modellen

Zu den Initiativen des US-Konzerns Nvidia im Bereich des maschinellen Lernens und der Simulation sagt Huber: „Da wurden viele Daten gesammelt. Mir fällt kein europäischer Konzern ein, der Ähnliches leisten kann.“ Er stellt aber auch fest: „Es ist ein Vorteil, so etwas einfach zu nutzen. Man begibt sich dadurch aber in eine Abhängigkeit. Alle großen KI-Modelle sind US-amerikanisch geprägt.“ In Europa gebe es nur kleinere Ausnahmen.

Sobald es um die Qualitätssicherung per Bildverarbeitung gehe, sind laut Huber aber die Anforderungen höher als beispielsweise bei der Navigation autonomer Fahrzeuge. „Da sind die Modelle nicht detailreich genug. Durch den nötigen Realismus sehe ich uns in einer Nische.“ Er spricht von „Sensorrealismus“ in Anspielung auf den Fotorealismus. „Wir müssen ein Bild so wahrnehmen, wie es die Kamera tut, und feinste Details erkennen. Mit solchen Anforderungen werden Systeme wie das von Nvidia normalerweise nicht konfrontiert.“ Deshalb glaubt Huber: „Das sind die Nischen, die wir als Europäer gut besetzten können.“

VDI-Konferenz „KI in der Produktion“ gibt vielfältige Einblicke

Huber ist einer der beiden Leiter des VDI-Kongress „KI in der Produktion“ Ende Februar 2025 in Leinfelden-Echterdingen. Neben dem Einsatz synthetischer Daten soll es dort Einblicke in weitere wichtige Facetten der künstlichen Intelligenz für die Produktion geben. „Wir haben ein reichhaltiges Portfolio an Vorträgen. Aus der Wissenschaft gibt es Einblick in die Grundlagen. Firmen beleuchten die praktische Seite anhand konkreter Lösungen. Da kann man aus erster Hand lernen, was heute machbar ist, aber natürlich auch, wo die Schwierigkeiten liegen. Darüber hinaus wird die regulatorische Frage adressiert“, sagt der Wissenschaftler vom Fraunhofer IPA.

Einblicke in die Forschung zur Verwendung generativer KI-Modelle

Eine Referentin ist Ruyu Wang, Forschungsingenieurin in der Bosch-Forschung. Sie gibt Einblicke in ihre Promotionsarbeit über die „Verwendung generativer Modelle zur Erzeugung synthetischer Daten, mit denen Modelle für die visuelle Qualitätskontrolle trainiert werden“. In ihrer Promotionsarbeit hat sie sich mit Prototypen und Voruntersuchungen auseinandergesetzt, um herauszufinden, ob die synthetischen KI-Daten hilfreich sind.

Ruyu Wang arbeitet als Forschungsingenieurin in der Bosch-Forschung. In ihrer Promotionsarbeit hat sie generative Modelle entwickelt, um synthetische fehlerhafte Proben zu erzeugen.

Foto: privat

Gegenüber VDI nachrichten erklärt Wang: „Dafür habe ich zwei generative Modelle entwickelt, um synthetische fehlerhafte Proben zu erzeugen, in Fällen, in denen echte fehlerhafte Proben fehlen. Das ist etwa bei hochoptimierten Produktionslinien mit nur wenigen fehlerhaften Teilen der Fall, oder auch bei neuen Produktionslinien, die gerade erst in Betrieb genommen wurden.“ Darüber hinaus untersuchte sie die Wirksamkeit der synthetischen Daten. „Die Ergebnisse zeigen, dass diese Technologie in Situationen von Vorteil ist, in denen defekte Proben knapp und schwierig zu sammeln sind, um einen Fehlerdetektor zu trainieren. Es ist jedoch auch wichtig, bei der Verwendung synthetischer Daten vorsichtig zu sein, da Daten von schlechter Qualität dazu führen können, dass das Modell die falschen Informationen lernt“, lautet eine ihrer Erkenntnisse.

Zum Zeitaufwand sagt die Forscherin: „Zum Beispiel ist in letzter Zeit die beliebteste Strategie, eine Feinabstimmung großer Bildmodelle wie ‚Stable Diffusion‘ vorzunehmen. Die nimmt nur ein paar Stunden in Anspruch. In diesem Fall wird nur ein Dutzend defekte Samples für das Tuning benötigt. Dann kann das feinabgestimmte Modell innerhalb weniger Sekunden oder Minuten ein synthetisches Bild erzeugen, je nach erforderlicher Auflösung und Qualität.“

Ein weiterer üblicher Weg sei es, ein generatives Modell von Grund auf mit dem Zieldatensatz zu trainieren. Die beiden generativen Modelle aus Wangs Promotionsarbeit wurden nach ihrer Angabe auf diese Weise trainiert. „In diesem Fall schwankt die benötigte Zeit für das Training je nach Größe des Datensatzes zwischen einigen Stunden und einigen Tagen. Die Zeit für die Erzeugung eines synthetischen Bildes reicht von wenigen Millisekunden bis zu wenigen Minuten.“

Ein Beitrag von: